2 Principes théoriques de modélisation des connaissances

« organiser le dialogue avec la Nature

en tissant inlassablement

le filet des énoncés

pour en resserrer la maille »

(Callon, 2013, sec. 37)

« Il y a partout des forces

qui constituent

des microcerveaux. »

(Deleuze & Guattari, 2005, p. 200)

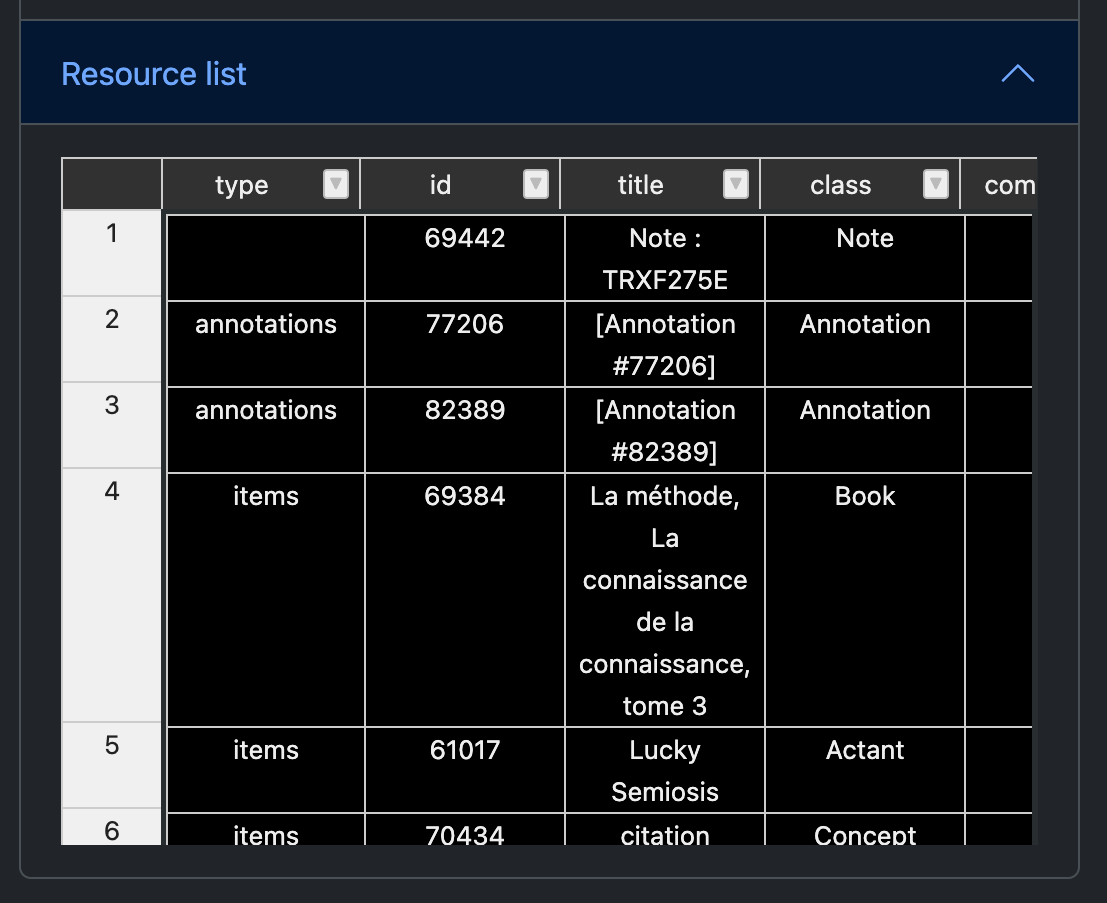

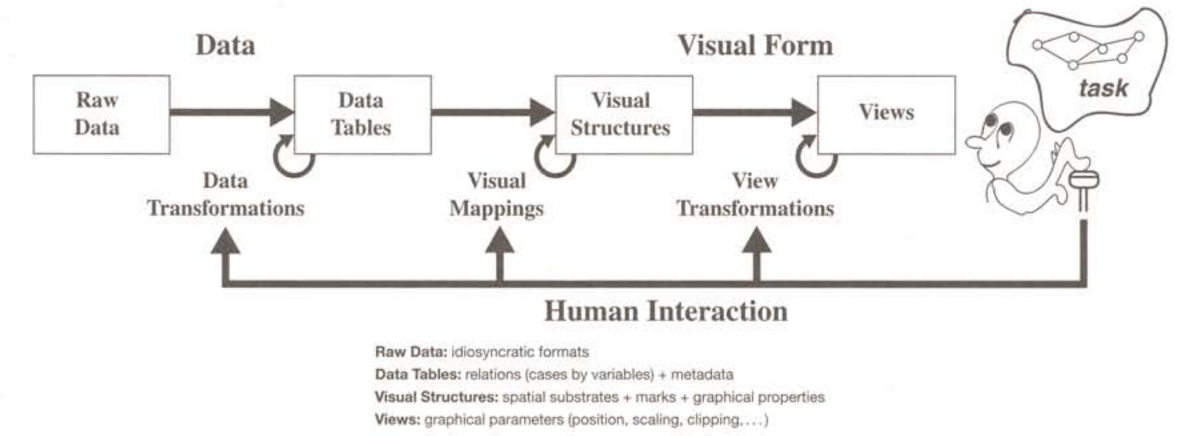

Depuis une trentaine d’années, je m’intéresse à la modélisation des données et plus particulièrement à la question de savoir comment cette modélisation est utile pour créer les conditions de l’expérimentation des connaissances. Dès mes travaux en maîtrise d’histoire de l’art (1994), je me suis familiarisé à la création de bases de données qui pour moi à cette époque, prenaient la forme d’un simple tableur. Puis en DEA (1995), j’ai découvert avec le logiciel Hypercard1 comment transformer mes tableurs en collections de fiches hypertextuelles (Deuff, 2019) et surtout en interfaces dynamiques et interactives. Ce passage à Hypercard m’a fait comprendre les relations intimes entre les données, leurs représentations et leurs manipulations que (Card, Mackinlay, & Shneiderman, 1999) a bien schématisé Figure 2.1 :

De plus, au même moment, mes recherches sur John Cage m’ont sensibilisée à deux approches opposées de ces relations entre données, représentations et manipulations. À travers les débats qui ont animé les rencontres entre John Cage et Pierre Boulez (Boulez, 1975), j’ai compris que les approches du hasard pour Boulez et de la chance pour Cage étaient symptomatiques d’un usage opposé des possibilités ouvertes par les ordinateurs et plus particulièrement de comment utiliser les méthodes aléatoires pour choisir des données et créer les conditions pour expérimenter des connaissances.

D’un côté Boulez soutient l’idée de :

« “hasard dirigé” pour parvenir à une complète négation du hasard qu’il nomme “le hasard absorbé” et qui garantit selon lui “la sur puissance du compositeur” »(Cazenave, 2006)

De l’autre côté, Cage utilise les possibilités aléatoires de l’informatique pour se dégager des puissances de son égo et parvenir à :

« trouver une façon d’écrire qui, tout en partant d’idées, ne soit pas un discours sur elles : ou ne soit pas sur des idées, mais les produise » (Scott Lee, 1998, p. 307)

Entre ces deux approches, il n’est pas nécessaire de choisir, mais plutôt de trouver comment les associer. L’approche de Boulez a montré l’efficacité d’une “sur puissance” pour construire des institutions de recherche comme l’IRCAM ou de diffusion de la musique comme la cité de la Musique. L’approche de Cage quant à elle, continue de questionner nos égos avec par exemple l’oeuvre musicale “As Slow as Possible” qui devrait se terminer en l’année 26402. Ce qui rapproche les deux créateurs c’est la volonté de définir un protocole (Sauret, 2020), c’est-à-dire de définir des règles d’information et de communication dans un processus de création. Ce qui les oppose c’est la place qu’ils donnent à l’ordinateur pour faire des choix dans les étapes du protocole. Boulez contraint le plus possible les choix de la machine et garde la responsabilité du choix final alors que Cage part d’une idée créative par exemple “le plus lent possible” et laisse la machine choisir les paramètres du protocole. Ces débats entre ces deux approches sont d’une extrême actualité à l’heure où nous cherchons à concilier les IA symboliques et connexionnistes. D’un côté, une intelligence artificielle connexionniste qui utilise l’apprentissage machine pour choisir automatiquement des modèles à partir de très grandes quantités de données. De l’autre, une approche symbolique qui modélise des espaces sémantiques pensés par des humains pour contraindre les choix de la machine. Là où le connexionnisme produit des modèles impensables par les humains, car trop complexes, l’approche symbolique organise cet “abîme réflexif” (Ertzscheid, 2023) de manière à le rendre plus compréhensible et pilotable par des humains.

Au cours de nos expériences professionnelles comme ingénieur informatique puis comme chef de projet et architecte de l’information, nous avons pratiqué l’approche “boulézienne” de modélisation des connaissances en utilisant des bases de données relationnelles (Saleh, 1992) et des interfaces de gestion orientée vers un travail bureautique. Dans le monde de l’entreprise, il faut contraindre le plus possible les données et leur manipulation pour optimiser les traitements et réduire le plus possible l’ambiguïté de l’information et de la communication. Cette approche trouve son aboutissement dans les “systèmes experts” piloté par des ontologies et des IA symboliques. J’ai montré dans ma thèse (Szoniecky, 2012, pp. 61–71) les limites formelles de cette approche de modélisation des connaissances notamment parce que :

« Son efficacité repose principalement sur une vision réductrice et fermée des pratiques cognitives, des situations d’échange transactionnel, des processus réels de travail, des différenciations dans les phénomènes essentiels de recherche, de navigation et d’écriture- lecture. » (Juanals & Noyer, 2010, p. 52)

Ces limites sont contrebalancées par le fait que ces approches possèdent une dimension sociale incontournable à cause :

du consensus nécessaire à leur élaboration,

de leurs adoptions qui lient les individus à la société,

du développement des systèmes symboliques vecteurs de nouvelles sociabilités

L’expérience de génération automatique de textes philosophiques que j’ai menée juste après mon DEA dans le cadre d’une licence de Philosophie par correspondance (Szoniecky, 2012, pp. 261–263) a été pour moi une première expérimentation de ce rapprochement entre modélisations symboliques et connexionnistes. D’un côté, j’ai utilisé la modélisation symbolique du classement des ouvrages dans la bibliothèque universitaire de Nanterre, de l’autre les capacités automatiques de sélection des ordinateurs. Même si à l’époque, les machines étaient très restreintes dans leurs capacités de choix, l’expérience a montré en quoi elles entraînaient une mutation du travail intellectuel. En conclusion de ma thèse, je m’interrogeais sur les capacités de l’institution universitaire à accepter « les travaux d’étudiants puisant dans les sources du Web une matière inépuisable à la génération automatique de connaissance » (Op. cit., p. 263) en laissant faire pour une grande part le hasard.

« il est très fréquent que le “choix au hasard” soit la meilleure stratégie offerte à un joueur. Mais l’esprit répugne […] à prendre une décision complètement arbitraire, et il préférera toujours à cet arbitraire la soumission à un modèle, si faiblement motivé qu’il puisse apparaître. » (Thom, 1975, p. 361)

Plus de dix ans plus tard, l’explosion des outils d’IA générative montre que les étudiants n’ont pas attendu que l’institution évolue pour changer leurs manières de produire des connaissances.

Face à ces usages incontrôlables et individuels des modèles connexionnistes à la base de ces IA génératives, il convient de réintroduire du symbolique dans les protocoles d’utilisation de ces technologies pour redonner une dimension sociale à la modélisation des connaissances et ne pas accentuer une « misère symbolique » (Stiegler, 2005) déjà très prégnante. C’est sans doute un des enjeux importants auquel nous devons faire face en tant qu’universitaires : comment développer cette dimension sociale de la modélisation des connaissances dans des processus d’intelligence collective ?

Nous montrerons dans le chapitre suivant comment ces processus peuvent s’appuyer sur une cartographie des connaissances Chapter 3, mais décrivons maintenant plus en détail les principes théoriques que nous définissons pour modéliser ces intelligences collectives dans des écosystèmes des connaissances.

2.1 Nos 8 principes fondamentaux d’information-communication

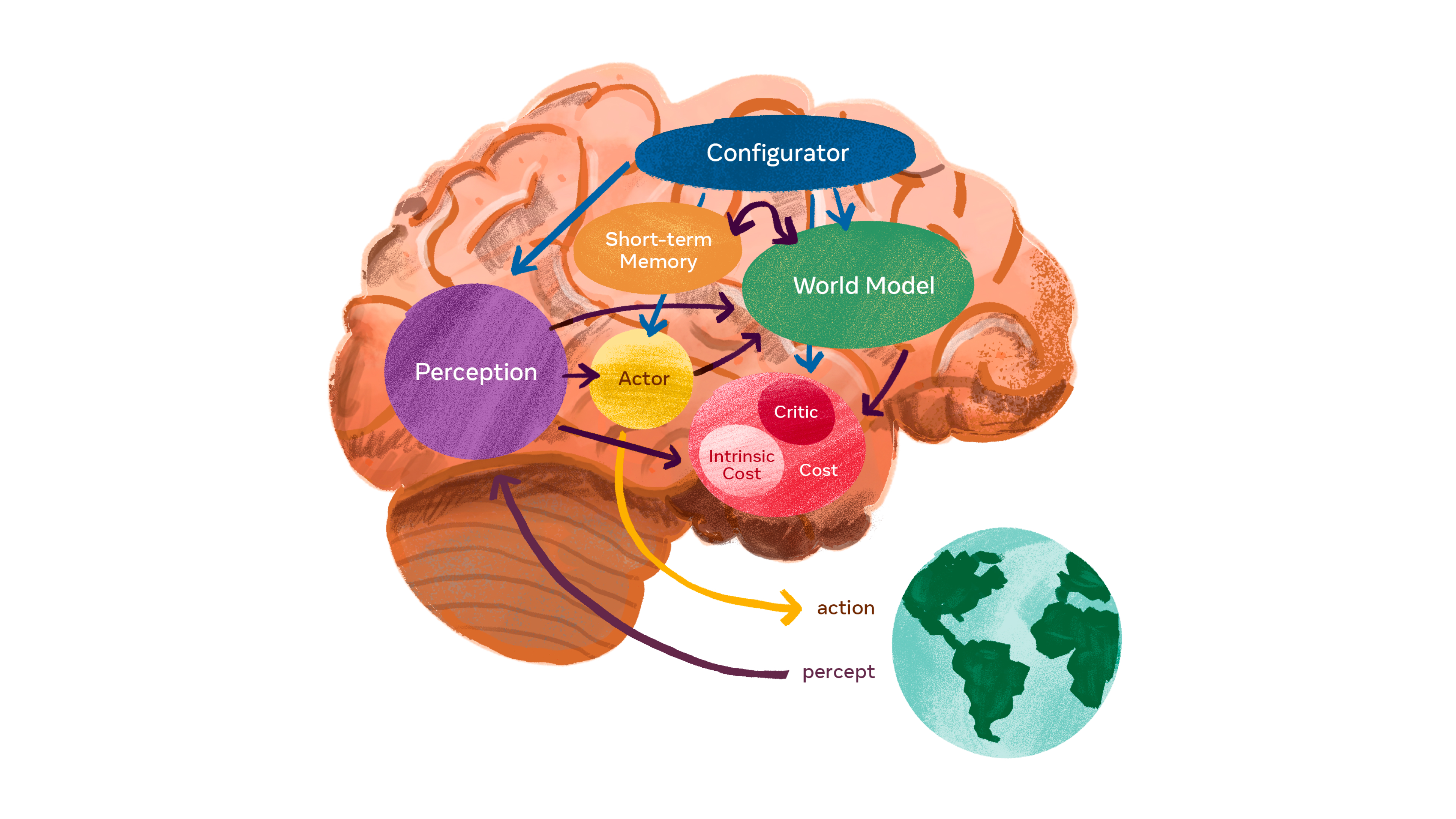

À l’inverse du modèle d’architecture de la perception que propose Yan LeCun (LeCun, n.d.), un des “technopapes” de l’IA connexionniste, dont la représentation visuelle Figure 2.2 symbolise parfaitement la disproportion entre son cerveau est notre planète, nous ne considérons pas la perception uniquement à travers une cervelle dont la transcendance extérieure à son environnement exerce son pouvoir sur un objet. Pour nous, l’information et la communication sont des processus qui se déploient dans un écosystème complexe (Bateson, 2008; Lévy, 1990; Maturana & Varela, 1994; Morin, 1995) qui émerge de l’autopoïèse et de l’auto-organisation d’une multitude d’existences possédant chacune un cerveau en rapport les uns avec les autres pour constituer une noosphère :

« La sphère noologique, constituée par l’ensemble des phénomènes dits spirituels,est un très riche univers qui comprend idées, théories, philosophies, mythes, fantasmes, rêves. […] Ce ne sont pas des “choses de l’esprit”. Ils sont la vie de l’esprit. Ce sont des êtres d’un type nouveau, des existants informationnels […] ils sont capables de se multiplier en puisant de la néguentropie dans les cerveaux humains, et, à travers eux, dans la culture qui les irrigue ; nos esprits et plus largement nos cultures sont les écosystèmes où ils trouvent,non seulement aliment, mais chance, risque. » (Morin, 1981, p. 340)

Notre ambition de modéliser cette noosphère à partir des existences qui la composent s’appuie sur des principes fondamentaux dont trois premiers reprennent ceux de la complexité :

principe dialogique : « L’association complexe (complémentaire/concurrente/antagoniste) d’instances, nécessaires ensemble à l’existence, au fonctionnement et au développement d’un phénomène organisé. » (Morin, 1992, p. 98)

principe récursif : « Un processus où les effets ou produits sont en même temps causateurs et producteurs dans le processus lui-même, et où les états finaux sont nécessaires à la génération des états initiaux. » (Morin, 1992, p. 101)

principe hologrammatique : « Le tout est d’une certaine façon inclus (engrammé) dans la partie qui est incluse dans le tout. L’organisation complexe du tout (holos) nécessite l’inscription (engramme) du tout (hologramme) en chacune de ses parties pourtant singulières ; ainsi, la complexité organisationnelle du tout nécessite la complexité organisationnelle des parties, laquelle nécessite récursivement la complexité organisationnelle du tout. » (Morin, 1992, p. 102)

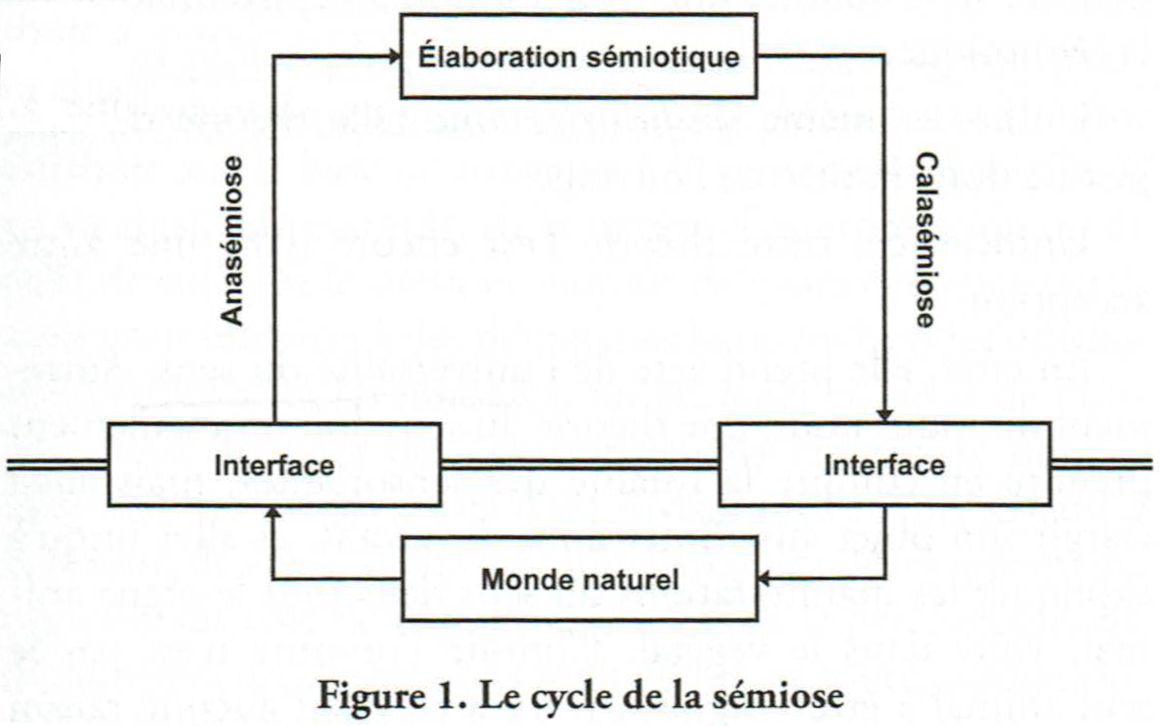

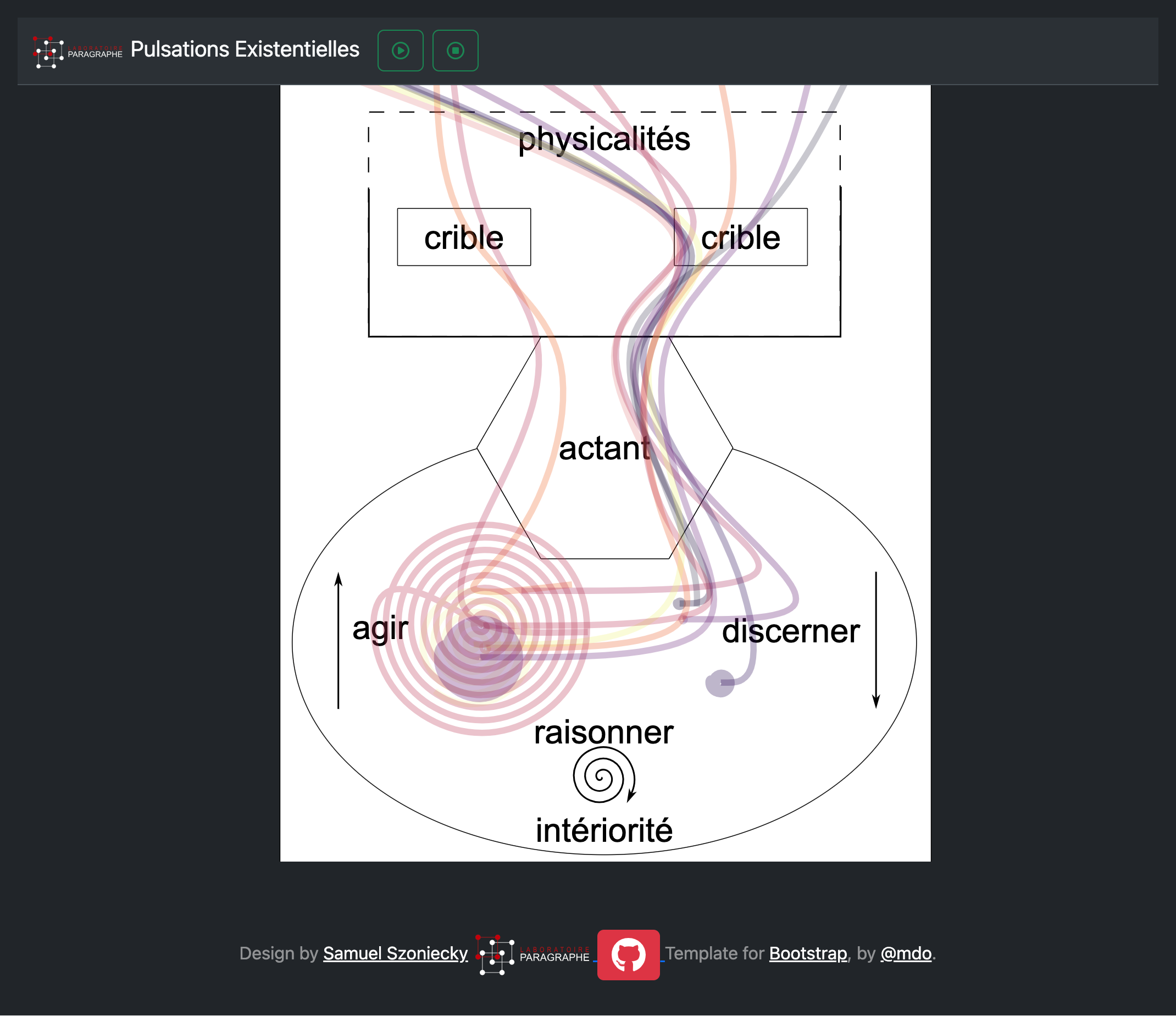

À ces trois principes de complexité, nous ajoutons un quatrième, le principe du cycle de la sémiose en considérant que les connaissances se produisent suivant un cycle continu d’expériences dans le monde physique et dans le monde de la pensée Figure 2.3. Entre les « physicalités » et les « intériorités » (Descola, 2005) , les « cycles de sémioses » (µ, Edeline, & Klinkenberg, 2015a) canalisent nos perceptions par « anasémiose » pour discerner des informations que nous communiquons et par « catasémiose » en donnant forme à l’agir : parler, lire, écrire, gesticuler, ne rien faire…

On nous basant sur les travaux de (Hofstadter & Sander, 2013) pour qui l’analogie est le « moteur » qui relie le discernement et l’action et ceux de Deleuze pour qui le “tissu de l’âme” par lequel Leibniz conçoit la perception, est composé de “plis”, nous définissons comme cinquième principe, le principe des plis analogiques qui à force de répétition construisent une manière d’être, un mode d’existence (Latour, 2012a) :

« L’opération de la perception constitue les plis dans l’âme, les plis dont la monade est tapissée du dedans ; mais ceux-ci ressemblent à une matière, qui doit dès lors s’organiser en replis extérieurs. » (Deleuze, 1988, p. 131)

À la manière de deux miroirs qui plient la lumière en se reflétant l’un dans l’autre à l’infini, discernement et action se réfléchissent en pliant les flux d’information. Chaque pli décompose l’information en signes dont les signifiés plongent vers l’intériorité en stimulant l’intuition et dont les signifiants émergent vers des physicalités en stimulant l’expression.

Entre discerner et agir, intuition et expression, c’est dans ce « milieu » qu’Augustin Berque décrit une « pulsation existentielle » mue par un sixième principe : principe de la raison trajective :

« la raison trajective, elle est en effet dans la pulsation existentielle qui, par la technique, déploie notre corps en monde sur la terre, et qui simultanément, par le symbole, reploie le monde en notre chair » (Berque, 2009, p. 402)

Cette raison pilote la réflexion en modifiant l’inclinaison du pli vers le discernement de signifiés ou vers l’expression de signifiants. Ce sont des processus que nous contrôlons consciemment en partie et d’autres plus imprévisibles et incontrôlables qui se produisent en fonction d’une multitude de pliages et de leurs capacités à se faire, se défaire, se bloquer suivant un septième principe, le principe des degrés de flexibilité (Clément, 2021).

Notre hypothèse principale que nous détaillerons plus loin Section 2.4.2 , est qu’il est possible de modéliser ces connaissances en formalisant les pliages et leurs dynamismes dans trois directions correspondant à trois pouvoirs fondamentaux :

discerner : pliage des physicalités extérieures vers l’intériorité,

raisonner : pliage en boucles récursives dans l’intériorité

agir : pliage de l’intériorité vers les physicalités extérieures.

À chaque pulsation existentielle, à chaque événement de nos vies, à chaque pli, ces pouvoirs augmentent ou diminuent, accentuant ainsi des rapports privilégiés, d’autres, plus secrets, et même certains qui nous restent inconnus. Ainsi, la pulsation varie continuellement, elle est parfois instantanée par exemple quand on rit, elle peut aussi prendre beaucoup de temps quand un souvenir longtemps oublié émerge petit à petit ; elle devient un métier quand à force de pratiquer un geste particulier, celui-ci s’automatise. Ces pulsations se transforment parfois en bêtises ou en inconscience quand le pouvoir d’agir prend le pas sur les pouvoirs de discerner et de raisonner en occultant leurs pliages potentiels. Suivant leurs fréquences, les pulsations existentielles forment des ondes dont la vitesse de propagation est fonction de leur longueur (distance séparant deux maxima consécutifs de l’amplitude entre physicalités et intériorité) et du milieu dans lequel elles se déploient. La catégorisation et l’analyse de ces ondes renvoient globalement à une réflexion sur la modélisation de l’esprit qui dépasse le cadre de ce propos, mais que nous illustration par le diagramme suivant Figure 2.4 :

Il découle de ces principes que le processus de modélisation des connaissances conçues en tant qu’existences informationnelles est assimilable à un calcul des puissances et de leurs évolutions :

« Si bien qu’à la question : ” Cet être existe-t-il ? ” il est prudent d’admettre qu’on ne peut guère répondre selon le couple du Oui ou Non, mais bien plutôt selon celui du Plus ou Moins. » (Souriau, Stengers, & Latour, 2009)

Ces opérations d’augmentation et de diminution s’appliquent aux puissances de discernement, de raisonnement et d’action d’une existence informationnelle et par la même définissent ce qu’elle peut, c’est-à-dire son éthique :

« Le point de vue d’une éthique c’est : de quoi es-tu capable, qu’est-ce que tu peux ? »3

Notre huitième et dernier principe que nous appelons principe ontoéthique reprend l’idée que défend Deleuze concernant la corrélation entre ontologie et éthique dans les propositions de Spinoza. Selon lui, les dimensions de l’existence et les genres de connaissances chez Spinoza sont corrélés. Ainsi la première dimension de l’existence, celle des parties extensives est corrélée au premier genre de connaissance celui des idées inadéquates, la deuxième dimension celle des rapports est corrélée aux notions communes qui forme le deuxième genre de connaissance et la troisième dimension existentielle, celle des essences, est corrélée au troisième genre de connaissances celui de l’intuition. Nous utilisons, une quatrième corrélation qui n’est pas présentée par Deleuze, mais qui reprend les propositions de (Callon, 2006) pour définir la dimension des actants corrélés aux connaissances sociales.

Dans le paragraphe suivant, nous détaillerons ces corrélations et présenterons comment en association avec les aux autres principes, nous proposons un métamodèle de modélisation des connaissances.

2.2 Métamodèle pour une ontologie - éthique

À partir des principes que nous venons du définir nous élaborons un métamodèle conçu comme « un générateur de modèles qualitatifs » (Thom, 1975, p. 372) que nous utilisons pour nos analyses de l’information et la communication.

2.2.1 Première dimension : la matière comme connaissances des chocs

À l’instar de (Bautier, 2016) nous pensons nécessaire « de prendre en compte la matérialité de la culture numérique ». Les technologies numériques véhiculent sans doute des idées de dématérialisation à travers des expériences de téléprésence, de virtualisation des échanges et d’autonomisation de la forme logique par rapport à la base matérielle. Mais peut-on encore parler de matière quand le contact avec l’événement se fait à travers des écrans, des réseaux, des milliers de kilomètres, des années, des algorithmes ?

Quoi qu’il en soit de cette « dématérialisation », nos connaissances numériques passent nécessairement par une dimension matérielle, car nous sommes nous-mêmes constitués de matière :

« La sémiose, loin d’être un phénomène sans lien avec le corps, tire son origine de celui-ci. Ce premier aspect de la corporéité du sens peut être qualifié de cognitif : le signe émerge de l’expérience, et ne saurait être étudié qu’à travers les interactions qu’il a avec son contexte » (µ, Édeline, & Klinkenberg, 2016, p. 2)

Les illusions que le numérique procure, tendent à nous faire croire à la dématérialisation en simulant par exemple des univers immersifs où nous vivons avec des avatars de toutes sortes (Amato & Perény, 2013) d’autres actualités que celles de notre corps. Mais en dernière instance, nous nous positionnons en tant que matérialiste (Comte-Sponville, 1998) : nous sommes matière et nous évoluons dans des espaces matériels.

Les interprétations par Deleuze de L’Étique de Spinoza décrive ces espaces matériels comme étant la première dimension de l’existence celle des « parties extensives » :

« Ces parties (corpora simplissima) […] se définissent uniquement par leur déterminisme extérieur, et vont toujours par infinités ; […] elles constituent la matière modale infiniment variée de l’existence.” (Deleuze, 2003a, p. 110)

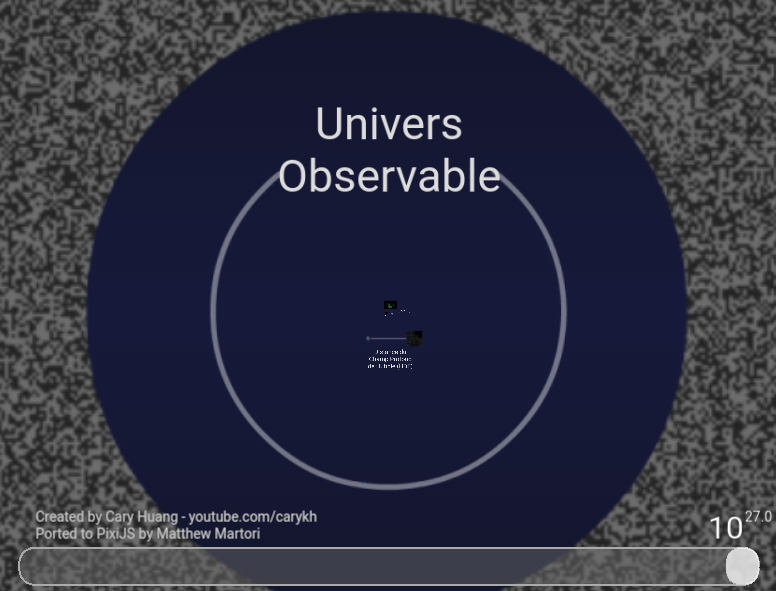

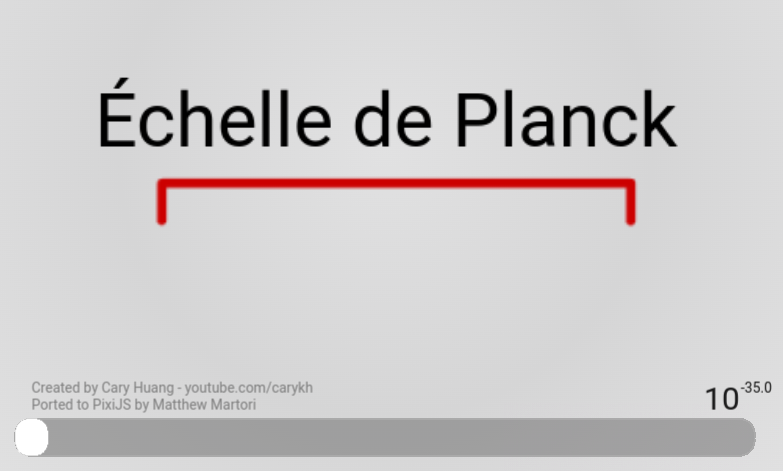

Entre l’infiniment grand Figure 2.5 et l’infiniment petit Figure 2.5 , les parties extensives sont observables et modélisables à toutes les échelles physiques de notre univers. Tout comme le choix d’une projection géographique reflète un point de vue particulier, celui des échelles de représentation contribue lui aussi à l’expression d’une subjectivité spécifique Section 4.1.

Les parties extensives correspondent aux « physicalités » des milieux que nous habitons, elles en sont l’indispensable matérialité. Cette nécessité de la matière est corrélée à des connaissances, elles aussi nécessaires, celles du premier genre de connaissance, les idées inadéquates :

« L’idée inadéquate, c’est l’idée inexpressive et non expliquée : l’impression qui n’est pas encore expression, l’indication qui n’est pas encore explication. » (Deleuze, 1968, p. 136)

Pour expliquer à quoi correspondent les connaissances du premier genre, Deleuze décrit dans un de ces cours l’expérience d’une personne au bord de la mer :

« Bien alors c’est quoi la connaissance du premier genre ? Eh bien allez, j’y vais, je me lance, je suis dans le premier genre de connaissance. Je me lance, je barbote, comme on dit. Qu’est-ce que ça veut dire barboter ? Barboter c’est tout simple, ça indique bien, on voit bien que c’est des rapports extrinsèques. Tantôt la vague me gifle, et tantôt elle m’emporte. Ça, c’est des effets de choc. C’est des effets de choc, à savoir, je ne connais rien aux rapports qui se composent ou qui se décomposent, je reçois les effets de parties extrinsèques. Les parties qui m’appartiennent à moi, sont secouées, reçoivent un effet de choc des parties qui appartiennent à la vague. » (Deleuze, 1981)

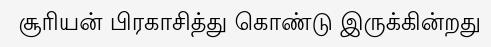

Donnons un autre exemple de ce premier genre de connaissance en vous invitant à faire l’expérience des parties extensives suivantes Figure 2.7:

Sauf si vous connaissez le tamoul, le texte ci-dessous est pour vous comme un choc, vous ne connaissez rien des rapports qui se composent ou se décomposent, vous ne voyez que les parties extensives du texte. Pour être plus précis, vous pouvez tout de même discerner des rapports puisque vous savez que l’image est un texte composé de caractères qui composent des mots séparés par des espaces. Par contre, vous n’avez aucune idée des concepts présents dans le texte, vous avez connaissance des signifiants, mais pas des signifiés4. D’une certaine manière, vous êtes comme un OCR (optical character recognition) capable de reconnaître des caractères et des mots dans une image. Mais à l’inverse d’une machine numérique qui avant la reconnaissance du texte décompose l’image en une multitude de points ayant chacun leurs coordonnées cartésiennes et leurs propriétés de couleur, vous commencez par reconnaître le texte puis vous le décomposez en mots et en caractères. Cette différence entre la machine et l’humain dans le processus de connaissances est au cœur d’une problématique fondamentale de la gestion mécanique du sens :

« il y a un conflit entre l’holisme du sens et le mécanisme de la syntaxe. Le sens d’un texte dépend de son contexte, le sens d’un paragraphe dépend aussi du texte dans lequel il s’intègre, le sens d’un mot du paragraphe qui le contient, etc. : le sens va du global au local, de la compréhension globale vers l’analyse. Or, le formalisme opère de manière inverse : le sens d’une formule logique se construit à partir du sens de ses parties, allant du local au global. » (Bachimont et al., 2011, sec. 11)

Ce conflit est d’autant plus flagrant quand le même texte est présenté dans une écriture que vous connaissez (Figure 2.8). Dans ce cas, vous ne faites plus la décomposition du texte en parties extensives le constituant, mais vous accédez directement à sa signification, car vous avez appris à lire, c’est-à-dire à discerner les compositions de rapports dans les parties extensives et vous accédez ainsi à un autre genre de connaissance celui des signifiants.

2.2.2 Deuxième dimension : les concepts comme connaissances des essences

À l’opposé des dimensions matériels-physiques et de la connaissance des chocs, nos connaissances se composent aussi dans nos intériorités :

« Par le terme vague d’ “intériorité”, il faut entendre une gamme de propriétés reconnues par tous les humains et recouvrant en partie ce que nous appelons d’ordinaire l’esprit, l’âme ou la conscience - intentionnalité, subjectivité, réflexivité, affect, aptitude à signifier ou à rêver. » (Descola, 2005, p. 168)

Comment modéliser ces dimensions intérieures et les connaissances qui leur sont corrélées ?

La question de modélisation de l’intériorité trouve des prémisses dans la question de l’évaluation des âmes et de leurs poids comme en témoigne l’iconographie de la pesée des âmes Figure 2.9 5. La psychostasie, nom donné à cette activité de mesurer le poids des âmes, touche historiquement les domaines de la théologie, de la philosophie et de l’éthique, mais intéresse aussi les sciences de l’information et de la communication qui cherchent notamment des réponses sur les conditions de la mesure, l’analyse et la critique de ces dimensions informationnelles qui ne sont pas mesurables de la même manière qu’une planche de bois ou qu’un nombre de livres rangés dessus, car elles ne sont pas soumises aux règles physiques de la matérialité tant qu’elles ne sont pas exprimées. Dès le passage de ces espaces intérieurs vers une forme d’expression quelle qu’elle soit (écrit, parole, clic sur un bouton…), ils se transforment en physicalités dont on pourra mesurer les paramètres physiques (hauteur, largeur, vitesse…). Ne peut-on modéliser ces intériorités qu’une fois exprimées par nos paroles, nos écrits, nos dessins, nos danses, nos activités corporelles… ?

Il faut sans doute passer par une forme d’expression pour que les impressions dans nos intériorités soient communicables, même s’il existe des connaissances intérieures qui restent secrètes, non par choix de ne pas les exprimer, mais par impossibilité de le faire soit parce qu’elles sont inconscientes, soit parce qu’elles relèvent d’une expérience incommunicable. De ce point de vue, nous n’adoptons pas la conjecture au cœur des recherches en IA depuis 1955, formulées à l’occasion du séminaire d’été à Dartmouth par John McCarthy, Marvin Minksy, Claude Shannon et Nathaniel Rochester (Leveau-Vallier, 2023, p. 39) qui prend comme principe que tous les aspects de l’intelligence peuvent être décrits avec une précision telle qu’une machine peut les simuler. Sans parler des connaissances mystiques qui n’existent que par le fait de les avoirs expérimentés ou non, pensons simplement aux connaissances qui émergent de nos intériorités à la lecture dans simple mot : aimer. Chacun d’entre nous expérimente la lecture de ce mot suivant ses propres histoires, ses états actuels et ses désirs ; ce que nous en communiquerons révélera ou non une partie de ces expériences que le mot aura fait résonner en nous. Nos intériorités sont le siège de nos subjectivités et des processus de signification que nous avons abordés en introduction de ce chapitre. Elles sont la dimension des élaborations sémiotiques qui transforment ce que nous percevons en action. Modéliser ces dimensions conceptuelles et avant tout un travail de réflexivité individuelle et de concentration sur ce que nous ne pouvons explorer que dans la solitude de notre propre conscience. L’enjeu qui nous anime ici est de fournir aux explorateurs de ces dimensions des modèles pour cartographier leurs explorations de manière à les rendre interopérables avec celles menées par d’autres.

2.2.2.1 Approches topologiques de la modélisation des concepts

Dans le domaine des sciences cognitives, les dimensions intérieures ont été pensé par (Gärdenfors, 2001) comme des « espaces conceptuels » en complémentarité des approches symboliques qui modélisent les systèmes cognitifs avec des machines de Turing et des approches connexionnistes qui modélisent avec des réseaux de neurones artificiels. Cet auteur propose de modéliser les espaces conceptuels à partir d’une représentation topologique des similarités qualitatives. La modélisation des espaces conceptuels par des topologies est sans doute une perspective intéressante pour représenter ces espaces, car elle permet de concevoir des espaces métriques à partir de la notion simple de voisinage. On peut considérer les concepts comme des points qui définissent un espace dans leurs rapports de voisinage avec d’autres concepts et calculer des distances entre ces points. Toute la difficulté est de définir les valeurs qui seront utilisées pour calculer la distance entre ces points. Gärdenfors propose d’utiliser des valeurs qualitatives pour calculer les distances par exemple les concepts de couleurs seront représentés dans une topologie dont les distances sont calculées suivants les qualités de nuance, d’intensité et de luminosité. L’avantage de cette proposition est de rendre pratiquement objective la distance entre les concepts, car celles-ci résultent d’une mesure physique. Mais de notre point vue, ces qualités font partie de la dimension matérielle que nous avons présentée plus haut (Section 2.2.1), elles ne peuvent donc pas être utilisées pour modéliser les concepts qui dans notre modèle relève d’une autre dimension existentielle, celle des essences (Section 2.2). Il est fondamental de préserver la multiplicité des points de vue à l’intérieur de ces espaces conceptuels et de ne pas les réduire à une mesure physique qui est la même pour tous, à tout moment, en tout lieu. Nous pensons que les espaces conceptuels sont propres à chaque individu; leur cartographie ne peut donc pas relever d’une mesure « universelle » liée à une métrologie physique. La distance qui sépare « aimer » de « haïr » n’est pas la même pour vous ou moi, pour hier, aujourd’hui et demain, ou suivant le lieu de mes rapports avec ces concepts. Nous verrons plus loin comment les dimensions existentielles des actants et des rapports nous permettent de cartographier ces fluctuations temporelles et spatiales (Section 3.5) retenons juste pour le moment que les principes de cartographie des espaces conceptuels ne peuvent se baser sur une mesure matérielle, car nous ne recherchons pas une mesure objective, mais tout au contraire, l’expression d’une subjectivité.

Contrairement à Gärdenfors, le langage IEML propose un « filet topologique » (Lévy, 2011, p. 257) dont les espaces métriques sont purement conceptuels puisque les rapports de voisinage sont définis suivant six concepts (être, signe, chose, actuel, virtuel, vide) associés à trois positions conceptuelles (substance, attribut, mode) sur six couches. Il en résulte une grille topologique très vaste : (6*6*6)6 soit 1,015599567×10¹⁴ positions possibles. Une infime partie de ces positions (34186) ont été interprétées, classifiées et référencées par Pierre Lévy et ses équipes pour donner du sens à cette topologie et fournir un vocabulaire de base utilisable avec un éditeur dédié à ce langage7. Cette solution de cartographie des espaces conceptuels est élégante et très ambitieuse, mais elle se confronte à plusieurs difficultés.

La première difficulté est qu’il n’est pas très facile de comprendre la complexité de ce langage et son utilité par rapport à des outils comme le moteur de recherche Google dont l’usage simplissime demande un effort minimal. IEML s’adresse à un public de spécialistes ayant des besoins très spécifiques et demande un investissement conséquent :

« IEML […] force à faire un travail d’analyse et de définition des concepts utilisés et fait apparaître de possibles paralogismes dans un raisonnement. » (Vitali Rosati, 2021).

La deuxième difficulté porte sur l’usage de ce langage qui ne correspond pas aux habitudes du public de chercheurs auquel il est destiné. Ceux-ci travaillent généralement des textes dans lesquels la définition et la critique des concepts est une part importante, mais le référencement de ces concepts par des thésaurus, des vocabulaires normalisés ou des langages formels est considéré comme un travail à la charge des documentalistes, des bibliothécaires ou des « ingénieurs sémantiques », nouveau métier que Pierre Lévy contribue à faire émerger. Le passage par un tiers en charge de traduire un texte écrit en langage naturel dans un langage sémantique comme IEML peut poser un problème liée à l’économie du processus éditorial qui est déjà soumis à de fortes pressions temporelles, financières et humaines. Toutefois, les progrès des IA générative laissent espérer qu’il sera bientôt possible d’utiliser des machines pour faire ce travail de conceptualisation des données (Lévy, 2023).

Une autre difficulté que nous avons expérimentée dans notre usage d’IEML depuis une dizaine d’années, c’est le manque de pérennité des outils mis à disposition pour gérer ce langage8. Cette difficulté inhérente à un travail de recherche « in progress », mais plus généralement aux langages informatiques qui évoluent au fil de temps rend délicat l’investissement important et constant que nécessite l’utilisation d’IEML.

Malgrès ces difficultés, ce magnifique projet mené par Pierre Lévy contribue à faire avancer l’utopie d’un dialogue plus fécond entre les humains grâce aux machines et nous est très utile pour concevoir la modélisation des dimensions sémantiques à partir d’outils simples permettant à chacun de construire ses propres représentations conceptuelles et donc de maîtriser le sens de ces représentations. Pour ce faire, nous avons conçu un outil de cartographie sémantique qui s’appuie sur les principes de la prétopologie (Belmandt, 1993; Thibault, 2017; Toumia, 2018) pour manipuler des concepts et leurs relations Section 3.4.

2.2.3 Troisième dimension : les actants comme connaissances des dynamiques génératives entre topos et chôra

Entre la dimension des physicalités organisée en hiérarchies et celle des concepts organisée en topologies, la dimension des actants organise les connaissances à la fois sous la forme de topos et de chôra (Derrida, 1997; Zamora, 2003). Topos et chôra sont deux manières complémentaires de modéliser soit pour le topos sous la forme d’une identité par exemple “Université Paris 8”, soit pour la chôra en définissant ce que le lieu génère comme activités, ce que sont ses dynamiques génératives, par exemple dans le cas de Paris 8 : recherches et enseignements.

« la chôra […] relève du monde sensible, non du monde intelligible. Inversement, la notion de topos, dans la mesure où elle concorde avec la logique de l’identité du sujet, relève moins de la sensibilité que de l’intelligibilité. » (Berque, 2009, p. 232).

Il est curieux de voir que dans l’histoire, topos et chôra se sont développés à travers deux manières d’êtres au monde (Latour, 2012b). On pourrait par exemple voir d’un côté une vision occidentale du topos dont les modernistes sont les héritiers et qui plonge ces racines chez Platon, Aristote et que l’on trouve aussi dans la Bible où la première activité de l’homme est de nommer les vivants pour définir leur identité :

« 2.19 : L’Éternel Dieu forma de la terre tous les animaux des champs et tous les oiseaux du ciel, et il les fit venir vers l’homme, pour voir comment il les appellerait, et afin que tout être vivant portât le nom que lui donnerait l’homme.

2.20 : Et l’homme donna des noms à tout le bétail, aux oiseaux du ciel et à tous les animaux des champs » (Jérusalem, 1993, p. 19).

.jpg)

Le topos fonde « en Occident la logique du tiers exclu » (Berque, 2009, p. 145) et caractérise les approches Naturalistes dont l’ambition est de décrire le monde de manière universelle (Descola, 2005). Du côté de l’Orient, le taoïsme apporte quant à lui une approche de l’environnement informationnel différente. Elle ne se base pas sur le nommage de l’identité, mais sur l’expérience des flux informationnels, des dynamiques génératives qui caractérisent la chôra, comme en témoigne Lao Tseu six siècles avant notre ère dans les deux premiers paragraphes du Tao Te King où il insiste sur le caractère indicible du Tao :

« 1. Le tao exprimable n’est pas Le Tao. 2. Le nom énonçable n’est pas Le Nom. » (Saint Girons, 2016).

L’opposition entre ces deux approches trouve aujourd’hui une actualité flagrante entre une IA symbolique qui fonctionne par nommage très précis des identités informationnelles sous la forme d’ontologies et une IA connexionniste qui privilégie l’émergence de modèle par des cycles récurrents d’apprentissages (Masure, 2023). Entre identité et dynamiques, les deux approches sont complémentaires notamment quand on cherche à modéliser les actants qui ne sont ni réductibles à leur identité ni à leurs activités. L’actant possède une identité qu’on définit basiquement par un nom et donc par une physicalité mais l’actant est aussi producteur d’activités et donc de dynamismes génératifs en créant des rapports entre des physicalités et des concepts (Section 3.6). Les actants sont topos de par les rapports qu’ils entretiennent avec les physicalités et chôra dans les processus internes d’émergence des connaissances intuitives issues des expériences de l’espace vécu. L’actant est donc le milieu de ces pulsations existentielles que nous décrivions plus haut Figure 2.4, il est le continuum entre les physicalités et les intériorités. Modéliser l’actant consiste donc à une double démarche à la fois de définition de son identité par des noms et de caractérisation des ces pouvoirs génératifs spécifiques (discerner, raisonner, agir). En se sens la représentation de l’actant est à la fois topologique et chorématique (Brandt, 2021; Reymond & Brunet, 1996).

2.2.4 Quatrième dimension : les rapports comme connaissances des existences potentielles

Les rapports sont la quatrième dimension de l’existence que nous utilisons pour modéliser les écosystèmes de connaissances. Ils composent la dimension existentielle qui relie les trois autres dimensions, les connaissances et les espaces qui leur sont associés : dimension physique, connaissances des chocs et espaces matériels hiérarchiques, dimension des concepts, connaissances des essences et espaces topologiques, dimension des actants, connaissances des dynamismes et espaces topographiques chorématiques. Les rapports définissent des espaces temporels, ils transforment une virtualité en actualité. Par exemple, je suis en tant qu’actant actuellement en rapport avec la physicalité de mon clavier et de mon écran qui produisent les concepts que vous lisez. Ces rapports ne seront plus actuels quand à la fin de cette séance de travail je commencerai une autre activité. Moi en tant qu’actant, mon clavier en tant que physicalités et ce que j’ai écrit en tant que concepts, nous existons toujours comme potentialités de futurs rapports qui s’instancieront à une date et pour une période données. En d’autres termes, les trois dimensions physique, actant, concept créent des potentialités de rapports qui s’instancient ici et maintenant dans l’actualité d’une existence informationnelle.

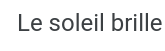

En résumé, le diagramme suivant Figure 2.11 que nous avons publié dans (Szoniecky, 2018), présente les dimensions de l’existence (physique, actant, concept, rapport) corrélées aux métriques (euclidienne, topographique, topologique, temporelle) permettant de les mesurer, aux concepts prétopologiques (extérieur, bord, intérieur, flux) permettant de les modéliser et aux analogies (branches, graines, racines, sève) permettant de les représenter :

À partir de ces corrélations, nous pouvons modéliser des écosystèmes connaissances et calculer l’importance des existences informationnelles qui la compose

2.3 La complexité existentielle

À partir des propositions que nous faisions dans les chapitres consacrés à la complexité existentielle que nous avons publiés dans (Szoniecky & Toumia, 2019), nous élaborons ici de nouvelles propositions sur la modélisation des connaissances en les corrigeant et les complétant de nouvelles propositions.

À partir des principes de modélisation que nous avons définis Section 2.1, il est possible de calculer la complexité d’un écosystème de connaissances suivant des règles génériques qui s’appliquent quels que soient les éléments qui compose l’écosystème concernés. La comparaison entre ces écosystèmes devient dès lors possible afin d’évaluer leurs étendues dans les connaissances et le degré de précision de celles-ci, mais aussi les variations de puissances dans les différentes dimensions. Insistons toutefois sur le caractère relatif de ces modélisations et des mesures de complexité qui en découlent. Il est illusoire de défendre l’idée que la modélisation puisse être exhaustive, elle relève toujours de la subjectivité de l’analyse qui choisit d’intégrer tel ou tel élément dans le modèle. Dès lors, ce qui est important c’est de pouvoir évaluer la complexité du modèle et de créer les conditions de son interopérabilité et de sa réfutabilité.

2.3.1 Calculer la complexité existentielle

La complexité d’un écosystème de connaissances est calculée à partir des existences informationnelles qui le composent en faisant la somme de ces existences et des éléments qui composent ses quatre dimensions : physique, acteur, concept et rapport. Suivant le principe de modélisation hologrammatique que nous appliquons, les éléments de chaque dimension se composent eux-mêmes d’existences informationnelles bâties sur le même modèle à quatre dimensions. De ce fait, la complexité d’une existence augmente suivant la complexité des éléments qui la composent. Une simple somme des éléments qui composent l’écosystème n’est donc pas suffisante pour exprimer sa complexité puisqu’elle n’indique pas par exemple les niveaux de modélisation entre élément et sous partie qui la compose. De ce fait, le calcul de la complexité existentielle doit être pondéré par les niveaux de modélisation de chaque élément. Par exemple, la modélisation de l’existence informationnelle de notre planète par la seule dimension conceptuelle « Terre » est bien moins complexe qu’une modélisation de cette existence qui inclut l’ensemble des existences « continents » qui la compose. Pour calculer cette différence de complexité, nous proposons de multiplier le nombre d’éléments de chaque dimension par le niveau de modélisation. Dans le cas d’une modélisation « Terre », nous obtenons la complexité : 1

- « Terre » : niveau 1 : 1 élément => complexité = 1 * 1 = 1

Si nous ajoutons à cette modélisation les « continents », nous obtenons la complexité 1+14 = 15 :

« Terre » : niveau 1 : 1 élément => complexité = 1 * 1 = 1

+

« Afrique », « Amérique du Nord », « Amérique du Sud », « Antarctique », « Arctique », « Asie », « Europe » : niveau 2 : 7 éléments => complexité = 2 * 7 = 14

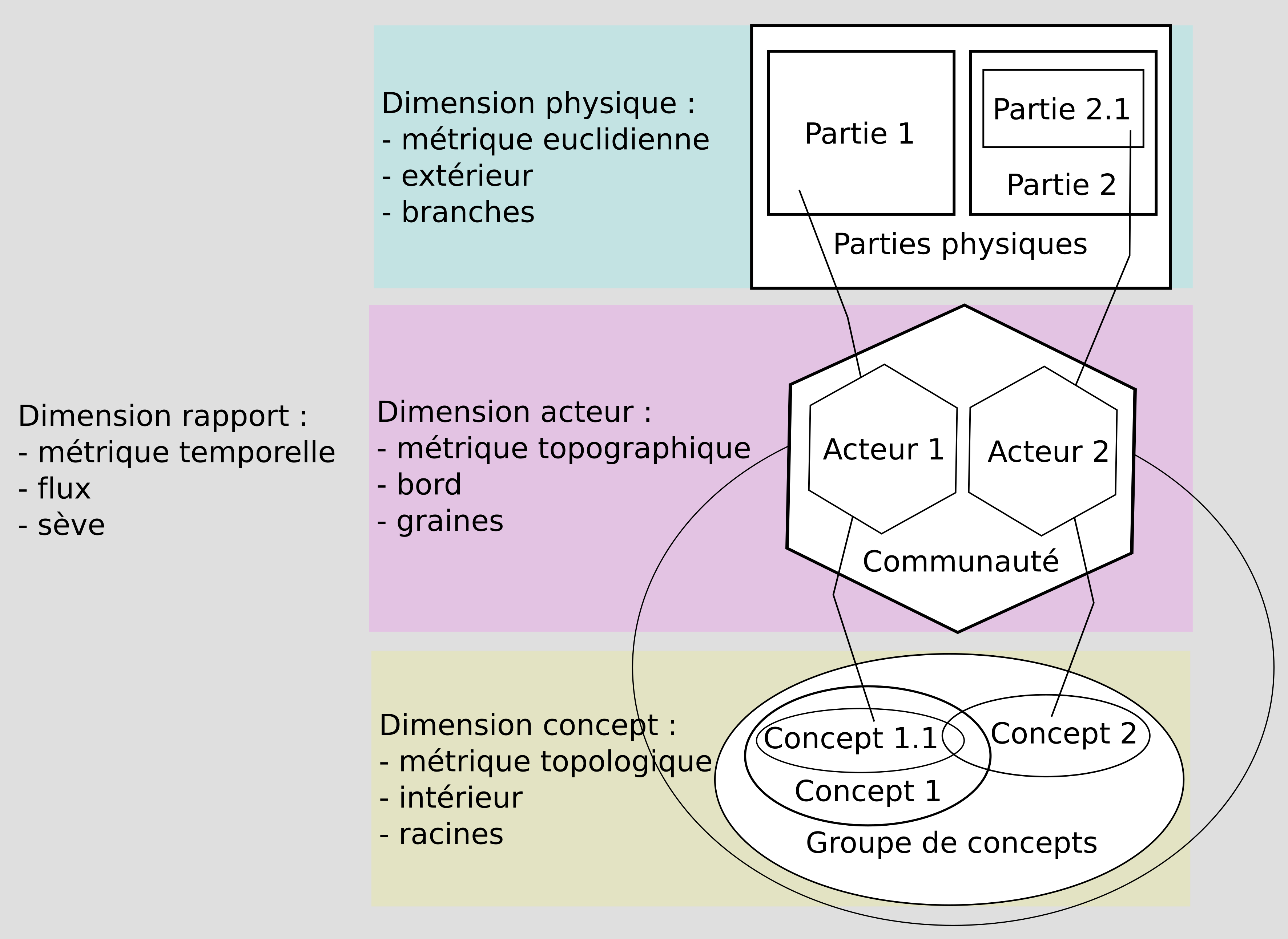

Pour faciliter ces calculs, nous avons développer un algorithme pour Omeka S9 qui utilise les informations de la base de données pour calculer la complexité d’une ou de plusieurs existences suivant le principe qu’une ressource Omeka S est une existence. Cet algorithme se compose de deux parties, une première qui calcule pour une ressource le nombre d’éléments de chaque dimension et une deuxième qui calcule la complexité à partir de ce dénombrement.

L’étape du dénombrement calcule pour chaque ressource le nombre d’éléments de la dimension existentielle correspondant à la classe10 de cette ressource. Puis incrémente le nombre d’actants pour chaque propriétaire (« owner ») de la ressource. Pour chaque propriété qui décrit cette ressource (une propriété est définie par une « rdf:Property » dans un vocabulaire spécifique), l’algorithme incrémente premièrement le nombre de concepts ; deuxièmement le nombre d’éléments physiques pour chaque valeur de la propriété puisque dans Omeka S, la propriété d’une ressource a une cardinalité 0-n. Dans le cas où une valeur de propriété est une relation vers une autre ressource, le calcul de complexité s’applique récursivement à cette ressource en augmentant le niveau de modélisation dans la limite de n+1 niveau11. Parallèlement au comptage des éléments des dimensions physique, actant et concept, l’algorithme incrémente la dimension des rapports en suivant le modèle logique sujet, objet, prédicat dont nous avons montrer l’intérêt pour un processus de modélisation dans (Szoniecky, 2020) et que nous détaillons plus loin Section 3.7. Avec cet algorithme, les valeurs des sujets, objets et prédicats sont définies avec les règles suivantes :

Pour chaque ressource :

sujet = dimension existentielle de la ressource, objet = Concept, prédicat = “properties”, nombre de rapport = nombre de propriétés

sujet = dimension existentielle de la ressource, objet = Physique, prédicat = “values”, nombre de rapport = nombre de valeurs pour l’ensemble des propriétés de la ressource

Pour chaque propriétaire

- sujet = dimension existentielle de la ressource, objet = Actant, prédicat = “owner”, nombre de rapports = 1

Pour chaque valeur de type ressource

- sujet = dimension existentielle de la ressource, objet = dimension existentielle de la valeur, prédicat = propriété de cette valeur, nombre de rapports = 1

Pour chaque valeur de type URI

- sujet = dimension existentielle de la ressource, objet = Physique, prédicat = “uri”, nombre de rapports = 1

Suite à cette étape de dénombrement, la deuxième partie de l’algorithme consiste à multiplier pour chaque ressource le nombre d’éléments de chaque dimension existentielle par le niveau de la ressource dans le processus de modélisation. Puis de cumuler les résultats pour obtenir la complexité d’un ensemble de ressources. Finalement, le calcul de la complexité produit l’objet avec les propriétés suivantes :

infos

date : date du calcul de la complexité

resources12 : liste des ressources impliquée dans le calcul avec les informations :

- type : le type de ressource omeka S = items, item set, media, annotations

- id : l’identifiant

- title : le titre

- class : la classe

- complexity : la complexité calculée

- d : la dimension existentielle = Physique, Actant, Concept, Rapport

- n : les niveaux de modélisation pris en compte pour cette ressource

- details13

params : affiche les paramètres passés à l’algorithme

Pour les dimensions Physique, Actant, Concept : résultats du calcul pour la dimension avec les informations :

details : liste les niveaux de modélisation, avec le nombre d’éléments et la complexité du niveau

totals : affiche le résultat total de la dimension :

- nbNiv : le nombre de niveaux de modélisation qui dans cette version de l’algorithme est toujours égal à 2

- nivMin : le niveau minimum de modélisation de la dimension : 1 ou 2

- nivMax : le niveau maximum de modélisation de la dimension : 2

- nb : le nombre d’éléments dans la dimension

- c : la complexité de cette dimension

Pour la dimension Rapport : résultats du calcul pour la dimension avec les informations :

details : liste des rapports avec les informations :

- ns : niveau de modélisation du sujet

- no : niveau de modélisation de l’objet

- s : dimension existentielle du sujet

- o : dimension existentielle de l’objet

- p : prédicat du rapport

- nb : nombre de rapports ayant les mêmes ns, no, s, o, p

- c : complexité du niveau

totals : affiche le résultat total de la dimension :

- nbNiv : le nombre de niveaux de modélisation qui dans cette version de l’algorithme est toujours égal à 2

- nivMin : le niveau minimum de modélisation de la dimension : 1 ou 2

- nivMax : le niveau maximum de modélisation de la dimension : 2

- nb : le nombre d’éléments dans la dimension

- c : la complexité de cette dimension

totals : affiche le résultat total des ressources calculées :

- nbNiv : le nombre de niveaux de modélisation qui dans cette version de l’algorithme est toujours égal à 2

- nivMin : le niveau minimum de modélisation : 1 ou 2

- nivMax : le niveau maximum de modélisation : 2

- nb : le nombre d’éléments

- c : la complexité

Les données fournies par l’algorithme sont enregistrées dans la base de données afin d’être utilisées pour faire d’autres traitements par exemple :

pour les représenter graphiquement,

naviguer dans les résultats,

analyser les existences,

définir des objectifs.

2.3.2 Représenter la complexité existentielle

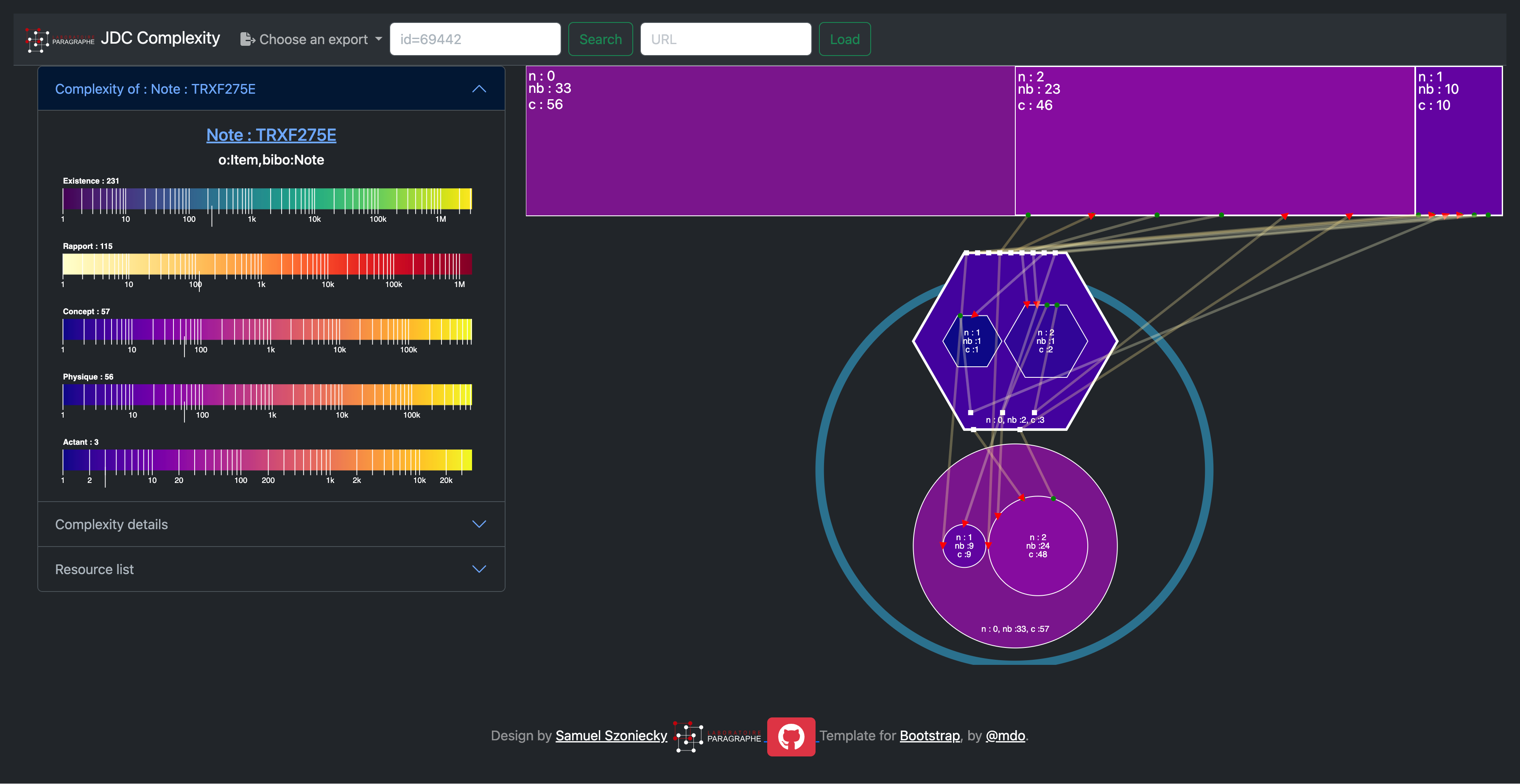

Afin de rendre plus explicite, la complexité d’un écosystème de connaissance et des existences qui le peuplent, nous avons conçu et développé une application de visualisation et de manipulation des calculs de complexité existentielle. Elle se base sur le modèle générique des existences informationnelles Figure 2.11 pour montrer l’importance des différentes dimensions existentielles avec une échelle colorimétrique.

Examinons par exemple, la citation suivante dans notre écosystème de connaissance :

« le tout est d’une certaine façon inclus (engrammé) dans la partie qui est incluse dans le tout. L’organisation complexe du tout (holos) nécessité l’inscription (engramme) du tout (hologramme) en chacune de ses parties pourtant singulières ; ainsi, la complexité organisationnelle du tout nécessite la complexité organisationnelle des parties, laquelle nécessite récursivement la complexité organisationnelle du tout. » (Morin, 1992, p. 102)

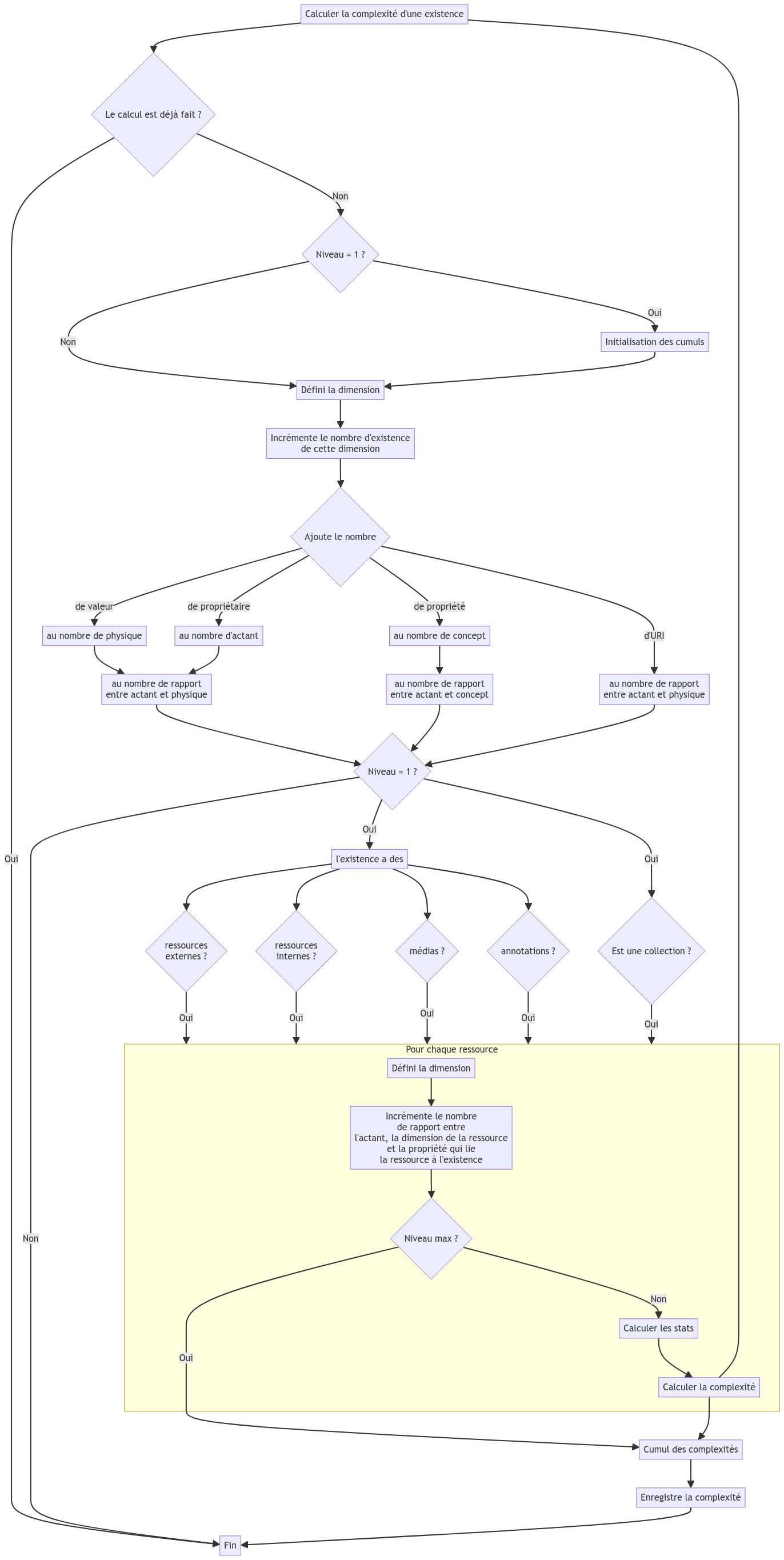

Le dernier calcul de complexité donne un total de 265 qui se décompose comme le montre la figure suivante Figure 2.13 :

Cette complexité peut se représenter par le diagramme suivant Figure 2.14 qui reprend le modèle général présenté plus haut Figure 2.11 et dont les principes cartographiques seront décrits en détail dans le chapitre suivant Chapter 3 :

2.3.4 Analyser la complexité des existences

La complexité existentielle obtenue par les calculs que nous venons de présenter est un indicateur très utile pour analyser un écosystème de connaissances. Par exemple, nous pouvons enrichir nos analyses des personnes participant à notre écosystème Chapter 6 en prenant en compte la complexité existentielle de ces personnes qui va de 7818 à 11 et qui donne un classement de leur importance par un simple tri sur cet indicateur.

Par exemple, si on examine le tableau des 20 personnes dont la complexité est la plus grande Table 2.1, on retrouve par ordre décroissant de complexité :

ma propre personne ce qui est normal puisque cet écosystème est le mien,

les collègues avec lesquels j’ai le plus échangé

les auteurs que j’ai le plus étudiés.

Notons que dans ce classement, on trouve aussi des anomalies par exemple la personne “Collectif” qui apparaît en troisième position renvoi non pas à une personne, mais à l’ensemble des ouvrages collectifs qui sont dans ma base de connaissances. Autres exemples d’anomalie, mon nom apparaît une fois sous la forme “Samuel Szoniecky” et une autre fois sous la forme “Szoniecky, Samuel”. Nous avons montré dans (Szoniecky, 2019) comment remédier à ce type de problème en liant les personnes à leurs références internationales (ISNI, VIAF, ORCID) grâce à une application Web dédiée à cet usage. Ce travail de consolidation est en cours dans notre écosystème. Dernier exemple d’anomalie, la présence des trois dernières personnes qui ont une complexité de 903. Ces personnes apparaissent très haut dans le classement, car le calcul de la complexité tel qu’il est aujourd’hui, produit un “effet de bord” en donnant plus de poids aux publications qui ont beaucoup d’auteurs, ce qui est le cas pour ces auteurs et les 10 autres qui suivent dans la liste. Le calcul de la complexité des existences montre ici son intérêt pour trouver des populations correspondant à un même type.

| Personne | Complexité |

|---|---|

| Samuel Szoniecky | 7819 |

| Imad Saleh | 3003 |

| Collectif | 2271 |

| Pierre Lévy | 1871 |

| Yves Citton | 1823 |

| Nasreddine Bouhaï | 1689 |

| Jean-Pierre Balpe | 1273 |

| Gilles Deleuze | 1261 |

| Hakim Hachour | 1191 |

| Orélie Desfriches Doria | 1153 |

| Khaldoun Zreik | 1115 |

| Manuel Zacklad | 1083 |

| Szoniecky, Samuel | 1053 |

| Jean-Max Noyer | 1025 |

| Sylvie Leleu-Merviel | 1013 |

| Bruno Latour | 939 |

| Takeo Kanade | 903 |

| Josef Kittler | 903 |

| Jon M. Kleinberg | 903 |

Une autre manière d’analyser la complexité d’un écosystème de connaissances consiste à observer les évolutions de la complexité pour une même existence. On peut ainsi suivre des étapes importantes de l’évolution d’une existence en suivant dans le temps les augmentations et les diminutions de sa complexité. Mon écosystème de connaissances est en constante augmentation puisque les existences informationnelles s’accumulent au fur et à mesure de mes recherches. Toutefois, il est possible d’observer l’importance de cette augmentation au fil du temps soit pour l’écosystème dans son entier, soit pour une existence ou mieux en comparant les évolutions de plusieurs existences. Nous donnerons plus loin d’autres exemples d’analyses d’un écosystème de connaissances à partir de sa complexité dans les perspectives de recherches que nous envisageons Chapter 4.

2.3.5 Définir des objectifs existentiels

Le dernier exemple que nous donnerons d’un usage des écosystèmes de connaissance à partir de sa complexité consiste à définir des objectifs à atteindre en modélisant une existence informationnelle de manière prospective. L’idée est de programmer l’évolution d’une existence entre différents états. Par exemple, dans le cas d’une production académique plutôt que de donner uniquement un nombre de caractères comme contrainte de production, il serait possible de donner un modèle d’existence avec des complexités à atteindre dans chaque dimension existentielle, voir même de définir des contraintes supplémentaires concernant tels documents, tels actants, tels concepts. De même concernant les rapports qui seraient définis spécifiquement en lien avec une modélisation de l’argumentation. D’autres exemples sont donnés dans nos perspectives de recherche Section 4.2.6 . Notons que cet usage de la complexité pourrait aussi servir à paramétrer très finement des IA génératives.

2.4 Modéliser les pouvoirs existentiels

Nous avons définis plus haut Section 2.1, 8 principes et 3 pouvoirs fondamentaux, examinons maintenant comment la complexité, les cycles de sémioses, les plis analogiques, la raison trajective, les degrés de flexibilité et l’ontoéthique structurent et produisent nos connaissances tout au long de nos vies en stimulant les pouvoirs de discerner, de raisonner et d’agir. Nous réfléchissons ici aux moyens de modéliser ces pouvoirs en prenant l’exemple du pouvoir d’agir et en le mettant en application dans un écosystème de connaissances du spectacle vivant.

2.4.1 Du pouvoir d’agir à la cartographie des affects

Le questionnement autour du pouvoir d’agir est relativement récent, il émerge de réflexions dans le champ de la psychologie du travail et de l’ergonomie. Dans ces domaines, on le définit dans ces relations aux

« conditions externes et internes au sujet, qui sont réunies à un moment particulier, comme l’état fonctionnel du sujet, les artefacts et ressources disponibles, les occasions d’intervention, etc. Il est toujours situé dans un rapport singulier au monde réel, rapport qui actualise et réalise la capacité d’agir en transformant les potentialités en pouvoir. » (Gouédard & Rabardel, 2012, sec. 9)

Cette transformation entre capacités et pouvoir se joue sur le terrain des compétences qui dans le cas des pouvoirs d’agir se limite à celles qu’un sujet peut mobiliser. À partir de cette définition, ces chercheurs ont conçu des outils basés sur des questionnaires et des entretiens pour analyser quantitativement et qualitativement le pourvoir d’agir des individus dans leurs activités et réfléchir à ses fluctuations. Cette démarche très intéressante fournit les bases d’une modélisation du pouvoir d’agir à partir d’une grille de codage composée de 5 paramètres :

| Capacité ou pouvoir d’agir | Position | Valeur (rapport d’état) | Dynamique évolutive | Attribution (à) |

|---|---|---|---|---|

| ca : capacité d’agir P : pouvoir d’agir |

c : constat d : demande r : refus p : projet |

> : trop = : assez (suffisant) < : insuffisant |

+ : augmentation # : état stable - : diminution |

s : soi-même a : autrui gs : un groupe qui inclut le sujet ga : un groupe autre |

Comme le remarquent les auteurs, cette méthodologie permet d’analyser finement le pouvoir d’agir des agents suivant « leur dynamique évolutive dans le temps, leur valeur et position du point de vue du sujet, leurs dimensions individuelles et de groupe. » (Ibid. § 91). Toutefois, elle ne propose pas de méthode générique pour modéliser le contexte où s’exprime le pouvoir d’agir. Il devient dès lors difficile de comparer des situations pour par exemple suivre les évolutions du pouvoir d’agir quand les éléments qui composent le contexte évoluent.

Dans un article récent sur le pouvoir d’agir dans l’analyse de l’activité, ce concept est analysé à la lumière des principes philosophiques de Spinoza pour qui

« le corps et l’esprit sont une seule et même chose exprimée, soit par l’étendue, soit par la pensée. En conséquence de quoi il faut comprendre qu’ils n’interagissent pas l’un sur l’autre, mais agissent et pâtissent ensemble » (Brun, 2017, sec. 22)

Comme nous l’avons déjà dit, l’intérêt de Spinoza dans une démarche de modélisation du pouvoir d’agir vient du fait qu’il propose de « faire une éthique qui serait comme le corrélat d’une ontologie » (Deleuze, 1981), c’est-à-dire une théorie de l’être qui fait correspondre la description d’une existence avec ses capacités d’action. De ce point de vue, modéliser ce qu’est l’existence renseigne sur son pouvoir d’agir. Suivant Spinoza, au cœur de cette modélisation de l’existence par son pouvoir d’agir se trouvent les affects qu’il définit ainsi :

« J’entends par Affections les affections du Corps par lesquelles la puissance d’agir de ce Corps est accrue ou diminuée, secondée ou réduite, et en même temps les idées de ces affections. » (Spinoza, n.d., p. 135).

Pour Brun (Op. cit. § 35), on peut organiser les affects en 3 variétés :

des affects primitifs psychophysiques,

des affects principalement physiques (choc, douleur…),

des affects principalement psychiques (repentir, satisfaction intellectuelle, amour…).

Ces affects entretiennent quatre types de rapports avec la puissance d’agir :

accroissement de la puissance d’agir du corps (la joie par exemple) ;

diminution de la puissance d’agir du corps (la tristesse) ;

catalyse du pouvoir d’agir (soutien positif au développement de la puissance d’agir) ;

contrainte, modération de la puissance d’agir.

Dans cette proposition rien n’est dit des moyens de décrire le contexte d’expression du pouvoir d’agir. Là aussi, impossible de comparer les analyses sans modéliser les conditions d’expressions des affects et s’interroger sur les bases nécessaires pour :

« esquisser une cartographie générale des dynamiques et des conditionnements censés relever d’une […] économie des affects ? » (Citton, 2008, p. 47)

En accord avec Yves Citton, les affects désigneraient :

« une réalité mentale consistant non pas directement en une connaissance d’un objet donné (réel ou imaginaire), mais en une certaine attitude subjective envers cet objet, attitude caractérisée par l’attrait ou le rejet, le plaisir ou le déplaisir. » (Citton, 2008, p. 70).

Plus précisément Citton en donne 6 « traits définitoires » :

l’affect relève d’une double réalité simultanément physique et psychique,

il est en rapport à une puissance d’agir d’affirmation ou de négation produisant des « actes d’âme » qui définiront un pouvoir de discernement spécifique dont nous parlerons plus loin,

ne relèvent des affects que les affections qui transforment (augmentation ou diminution) la puissance d’agir de ce corps,

il participe toujours d’une force d’affirmation même si elle ne fait que le traverser et diminuer sa puissance d’agir,

un affect inadéquat, une passion, cesse de l’être quand nous en formons une idée claire et distincte,

les affects conditionnent nos pensées.

Nous détaillerons plus loin Section 3.8 comment concevoir cette cartographie des affects, examinons maintenant comment définir le pouvoir d’agir comme élément constituant une perspective plus large, celle d’une sémiotique générique.

2.4.2 Vers une sémiotique générique

Nous avons déjà présenté Section 2.1 le cycle de la sémiose comme quatrième principe fondamental de la modélisation des connaissances. Revenons, plus en détail sur ce principe pour expliquer la production du sens proposée par (µ, Edeline, & Klinkenberg, 2015b). L’intérêt de cette proposition est de décrire la production du sens comme un cycle continu de relations dans un contexte produisant trois processus : anasémiose, élaboration sémiotique et catasémiose.

L’anasémiose est la capacité de discerner dans l’univers des possibles les informations d’où le sens pourra émerger ; elle exprime un pouvoir de discernement que Deleuze appelle « âme » en référence au crible constitué par le « tissu de l’âme » chez Leibniz (Deleuze, 2003b) et que les auteurs du diagramme appellent « interface ».

L’élaboration sémiotique est la capacité de raisonner avec les informations pour choisir des significations. Même si ce choix ne se résume pas à un processus raisonnable, nous parlons ici de pouvoir de raisonner pour insister sur la dimension constructible du sens qui est très utile pour une pédagogie de l’argumentation et de l’esprit critique. Nous gardons aussi ce terme de “raisonner” parce que son homonyme “résonner” renvoie au « trou noir » de la pensée due à l’imprédictibilité de ce processus qui se déroule dans un espace chaotique constitué d’une infinité de chaînes signifiantes au déploiement illimité. Pourquoi face à une blague faite par un conférencier, une partie de l’assemblée choisit d’exprimer un rire, une autre un sourire alors que d’autres n’y comprennent rien ?

La catasémiose transforme les informations signifiantes en actions dans le monde des possibles (rire, sourire, rien…) à travers une interface (cordes vocales, visage, texte…), ce processus de catasémiose est l’expression du pouvoir d’agir.

Le cycle de la sémiose met donc en jeu successivement trois processus correspondant à trois pouvoirs : le pouvoir de discernement (anasémiose), le pouvoir de raisonner (élaboration sémiotique), le pouvoir d’agir (catasémiose). Aux deux extrémités du cycle se trouve l’interface qui transforme la matière en pensée (discernement) et la pensée en matière (agir), elle est le « crible » par lequel passent les « pulsations existentielles » (Berque, 2009, p. 402) qui plongent dans l’intimité de nos élaborations et rebondissent jusqu’à la surface de nos expressions en élimant les « valeurs » superflues et en se chargeant des « valeurs » importantes. Ce crible, Descola propose de le structurer à partir de « matrices ontologiques » (Descola, 2005, p. 323) qui définiront les rapports entre physicalités et intériorités. (Hofstadter & Sander, n.d., p. 233) nous expliquent que nous élaborons ce crible par adoption et création d’un réseau d’analogies de plus en plus complexes. Ces auteurs venant de la sémiologie, de la géographie, de l’anthropologie, de l’intelligence artificielle et de la psychologie s’accordent pour dire qu’il est possible de modéliser cette interface, ce crible, ces rapports, ce réseau d’analogies qui va guider nos affects pour augmenter ou diminuer ce que nous discernons parce que nous agissons et vice-versa.

2.4.3 L’écosystème du spectacle vivant

Modéliser le pourvoir d’agir consiste donc à décrire l’interface, le crible, par lequel s’exprime ce pouvoir dans un cycle continu entre discernement des matérialités du monde et élaboration sémiotique. Parce que résultant d’un cycle, ce crible évolue en permanence. Il nous faut donc concevoir la modélisation comme un processus de génération successive d’états particuliers. En accord avec le principe d’énaction (Maturana & Varela, 1994, p. 241), le crible évolue dans un couplage avec d’autres cribles, l’évolution de l’un entraîne l’évolution des autres et réciproquement. La modélisation se doit de préserver ce couplage à toutes les échelles.

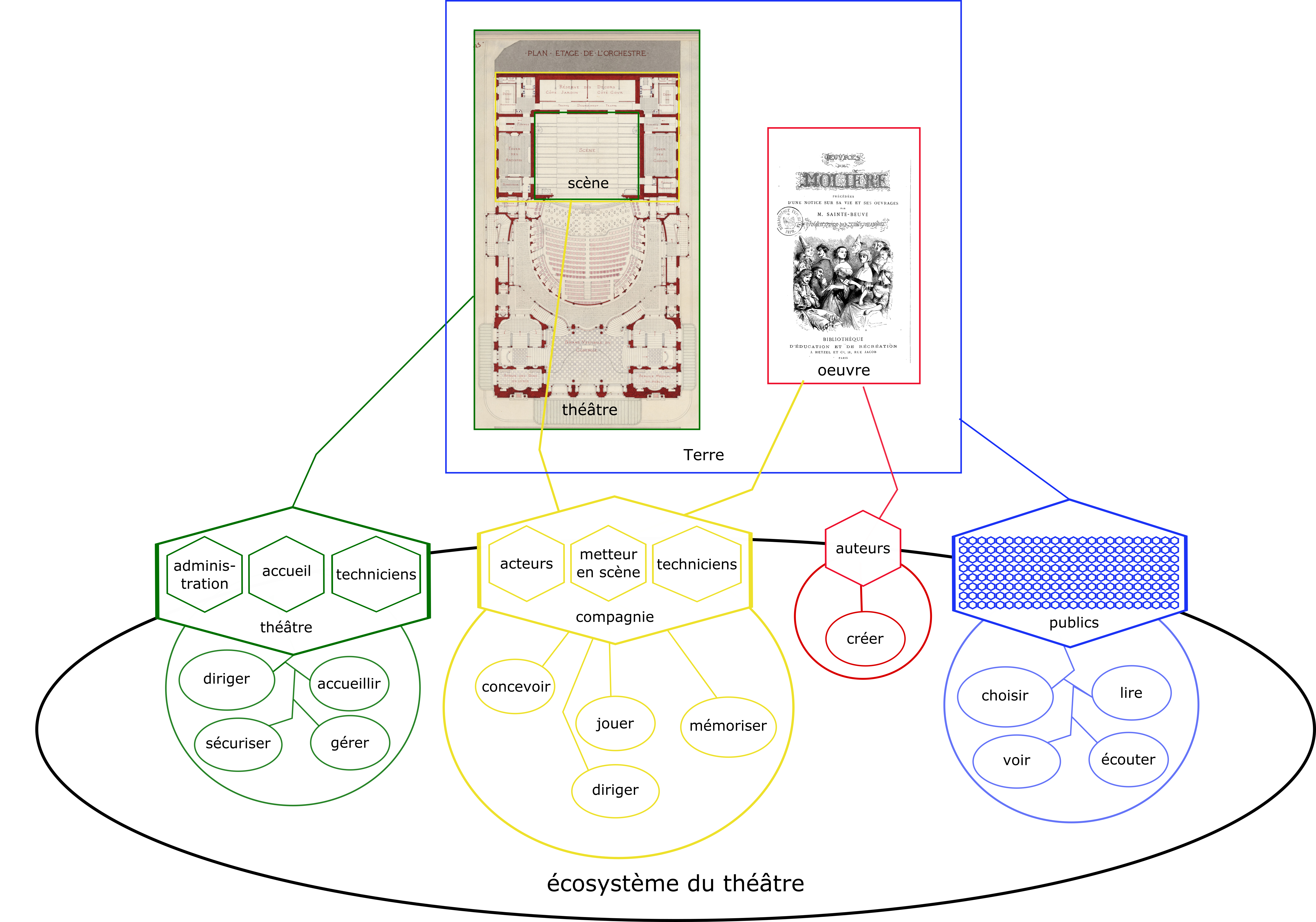

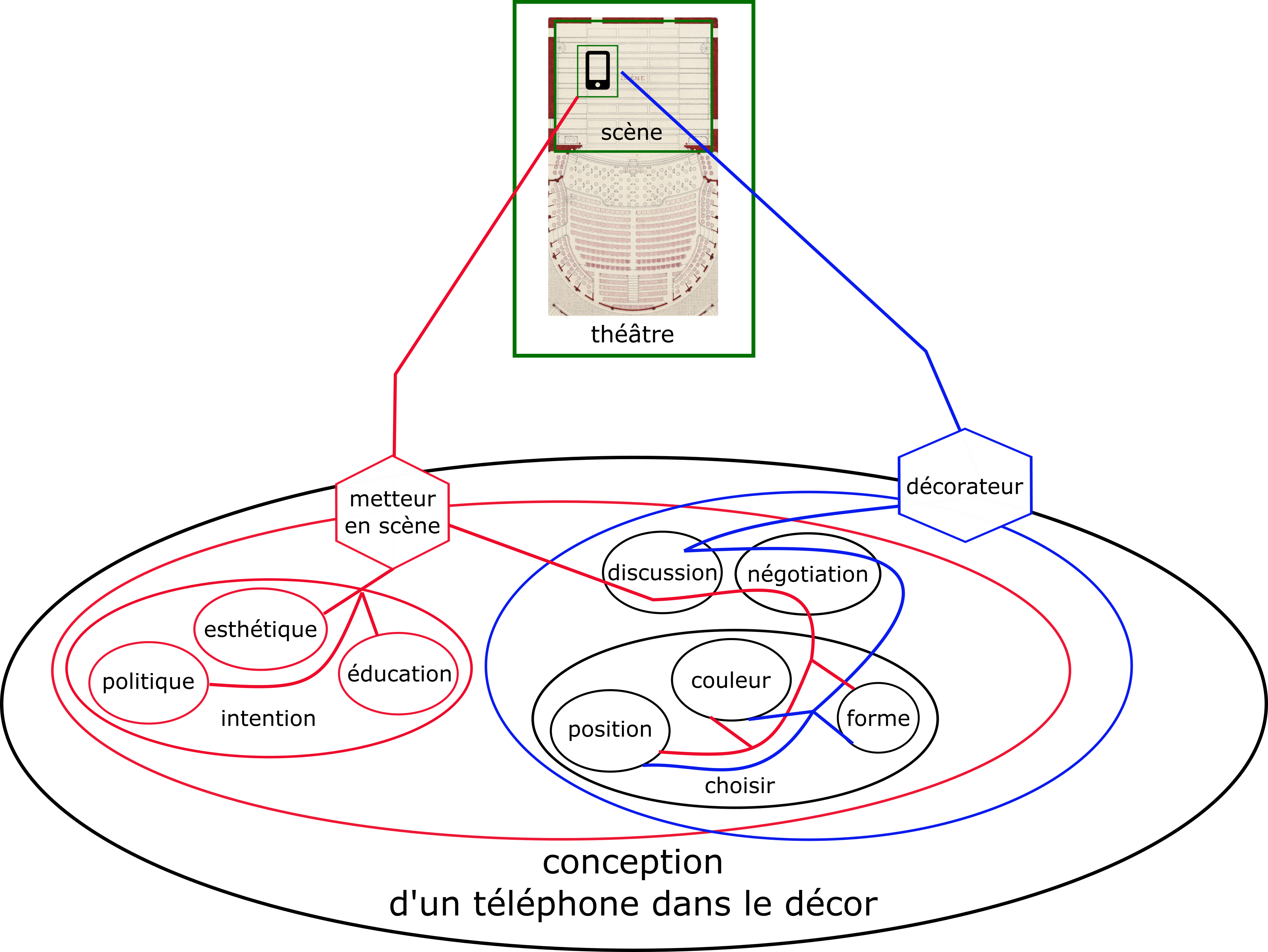

En lien avec le travail de thèse de Gabrielle Godin (Godin, 2024)sur l’usage des dispositifs numériques dans la médiation du spectacle vivant, nous développons ici un exemple où il faut modéliser à la fois le crible du spectateur, de l’institution théâtrale, du texte de la pièce, de l’interprétation d’un comédien, etc., mais aussi les relations que ces éléments entretiennent les uns avec les autres. Pour ce faire, nous concevons le crible suivant une structure fractale c’est-à-dire que chaque niveau d’échelle est constitué de la même structure. Chaque crible est considéré comme un « existant informationnel » (Morin, 1981, p. 340) composé d’une multitude d’existants plus précis et composant une multitude d’existants plus globaux, chaque existant étant modélisé suivant le même modèle générique, le tout composant un écosystème particulier. Nous avons présenté plus haut le modèle qui rassemble ces principes Figure 2.11

À partir de ce modèle générique, nous pouvons modéliser dans l’écosystème de connaissances du spectacle vivant un des états possibles d’une pièce de théâtre :

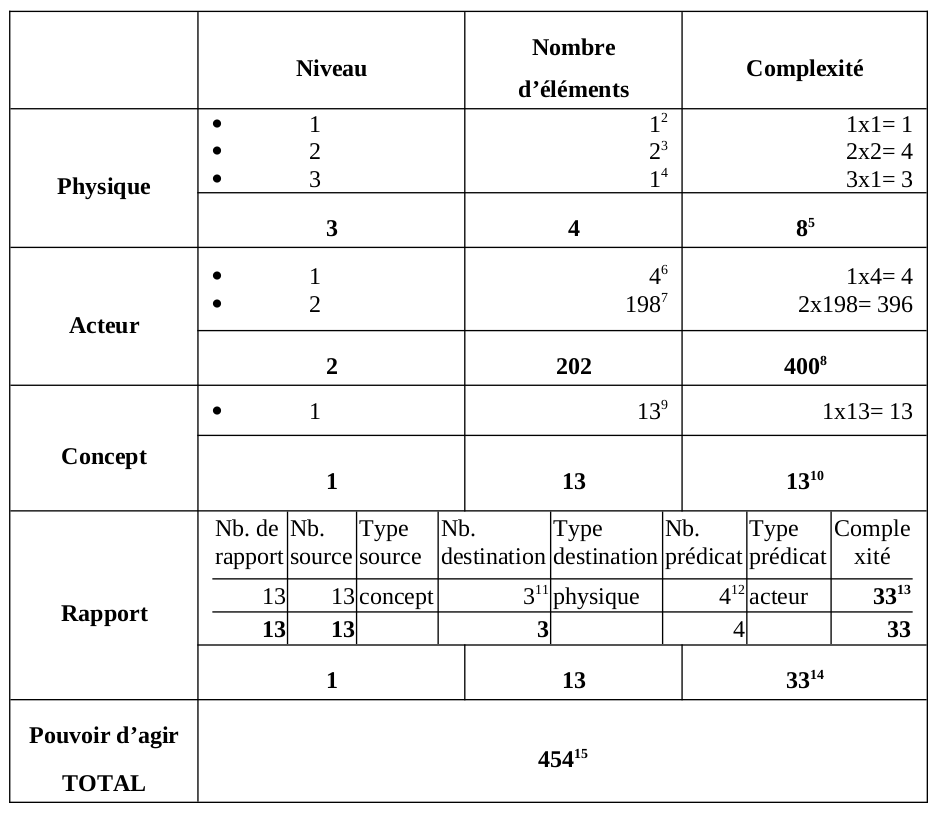

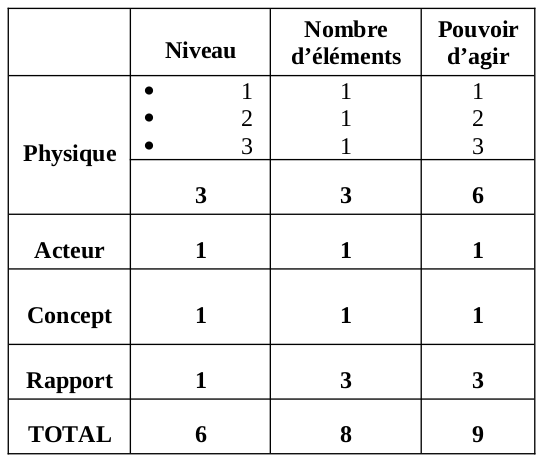

Le diagramme ci-dessus montre comment modéliser une pièce de théâtre suivant un point de vue relativement classique. Cet état de l’écosystème n’est en aucun cas exhaustif, il reflète juste les intérêts de son auteur : ce qui pour lui est important. La modélisation est avant tout un support d’interprétation et de réflexivité individuelle et collective. À partir de cette proposition, il convient de discuter ce qui est acceptable, ce qui manque, ce qui n’a aucun intérêt, ce qui doit être détaillé… Pour faciliter ces discussions, nous proposons d’utiliser le modèle des existants informationnels pour que tous les participants aux débats sachent interpréter ce que l’auteur du diagramme communique et comparent facilement différents points de vue en analysant les éléments qui composent l’écosystème modélisé. Dans le cas de la figure Figure 2.16 l’existant principal est appelé « écosystème du théâtre », il se compose d’un ensemble d’éléments dans les quatre dimensions de notre modèle (physique, acteur, concept, rapport). La description détaillée de ces éléments permet de calculer la complexité existentielle14 de cet existant :

Une complexité totale de 454 pour cette modélisation de l’écosystème du théâtre n’a de sens qu’en comparaison avec d’autres modélisations qui pourront être plus ou moins complexes dans les quatre dimensions existentielles. Par exemple, une salle accueillant plus de public fera croître la complexité de la dimension acteur. De même, un détail plus approfondi des rapports entre les concepts et les acteurs pour exprimer « qui fait quoi ? » augmentera la complexité de la dimension rapports. Bien évidemment, la complexité de la dimension physique peut être augmentée en détaillant chaque siège de la salle ou chaque mot de l’œuvre pour en faire des éléments autonomes.

Cette modélisation des existants et le calcul de complexité qu’elle génère nous renseignent très précisément sur le pouvoir de discernement explicite de l’auteur du modèle et sur le pouvoir d’agir potentiel de l’écosystème. En choisissant tel ou tel aspect de l’existant, l’auteur de la modélisation indique ce qu’il discerne dans les infinies possibilités de description du monde et par là même crée les potentialités des pouvoirs d’agir qui exprimeront ou non ce discernement. Que l’acteur de l’expression en soit conscient ou non, l’observation de son action à travers le crible de discernement défini par la modélisation renseignera sur son pouvoir d’agir. Notons que cette observation n’est pas uniquement le fait d’humains, mais peut tout à fait être automatisée en analysant les traces d’activité des individus avec un dispositif numérique. C’est ce qu’en font notamment les GAFAM pour cerner notre pouvoir d’agir dans un discernement principalement orienté vers la consommation de produits. Mais avec le modèle que nous proposons, cette expression du pouvoir d’agir ne s’oriente pas uniquement vers les produits matériels qui selon Spinoza, correspondent à la dimension physique et à une expression inadéquate qui est vectrice de tristesse. Les modélisations peuvent tout aussi bien s’exprimer dans les autres dimensions, celle des acteurs pour développer une connaissance sociale, celle des rapports pour développer une connaissance logico-pragmatique, celle de concept pour développer une connaissance intellectuelle intuitive afin de sentir et d’expérimenter « que nous sommes éternels » (Deleuze, 2001).

Plus encore, l’intérêt de cette méthode de modélisation écosystémique vise l’apprentissage de la réflexivité par rétroaction du pouvoir d’agir sur le pouvoir de discernement. En effet, le pouvoir de discernement crée la potentialité d’un pouvoir d’agir qui en retour, modifie le pouvoir de discernement dans un cycle continu tant que l’utilisateur de ces pouvoirs adopte une démarche réflexive.

2.4.4 Pouvoir d’agir d’un dispositif numérique

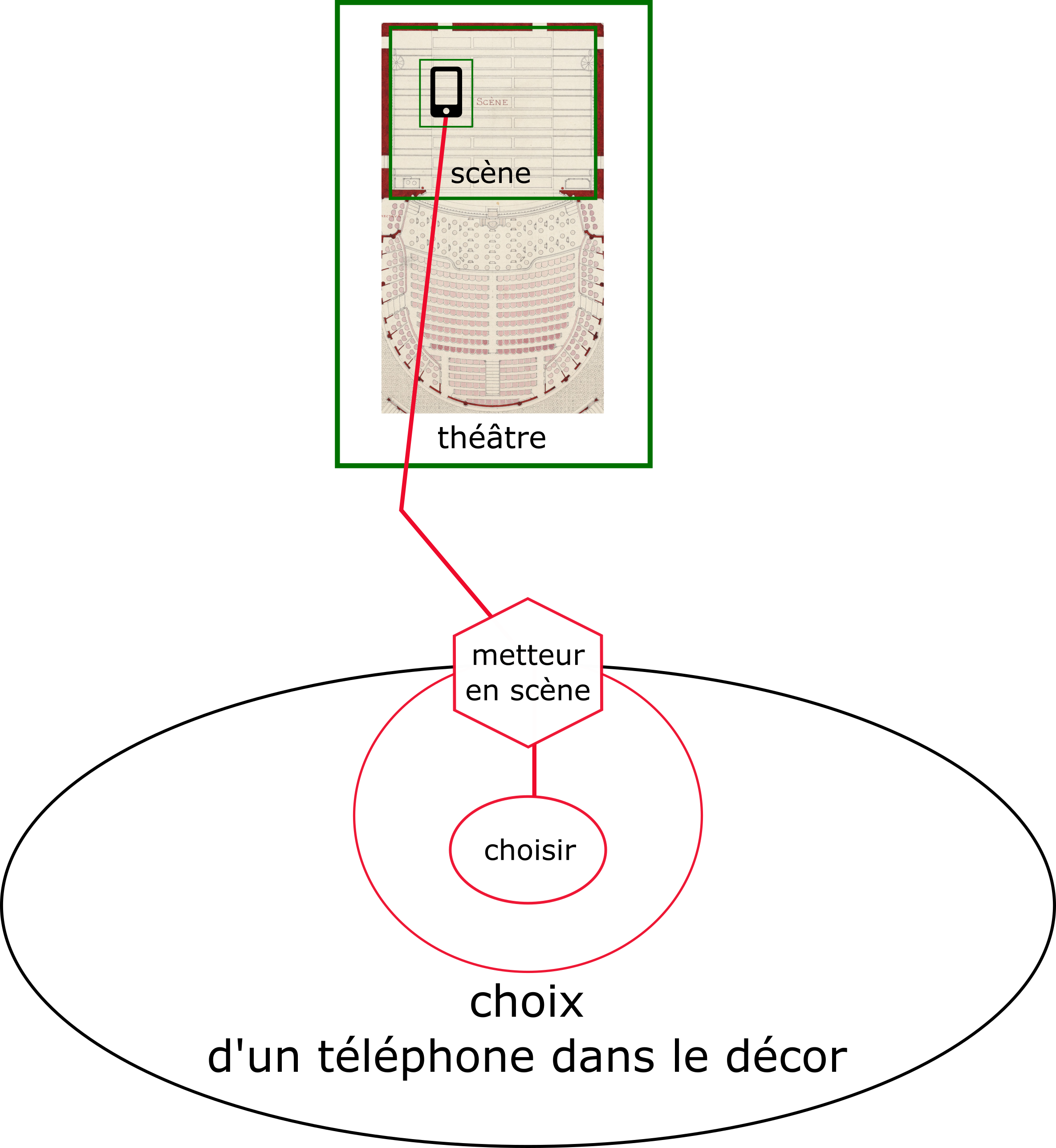

Reprenons l’exemple de l’écosystème du théâtre que nous avons décrit plus haut en y ajoutant un dispositif numérique afin d’évaluer en quoi il fait évoluer le pouvoir d’agir de cet écosystème. Pour guider notre évaluation, nous modélisons l’ajout de ce nouvel élément dans l’écosystème en décrivant dans un premier temps quelles dimensions existentielles il occupe. Suivant la place qu’il prend dans ces dimensions, l’élément aura un pouvoir d’agir particulier. Quels sont les éléments physiques ? Ont-ils des capacités d’action dans l’écosystème ? Quels rapports sont instanciés par qui ? Vers quoi ? Comment ? Quels sens les acteurs expriment-ils ?

Dans le cas d’un élément physique, son pouvoir d’agir est de l’ordre du choc : il informe de l’espace qu’il occupe par contact avec sa matière. C’est par exemple un téléphone portable dans la poche d’un spectateur ou placé dans le décor sur la scène. Dans le premier cas, le pouvoir d’agir s’exprime uniquement par rapport à une personne alors que dans le cas d’un objet du décor le pouvoir d’agir touche l’ensemble de l’écosystème du théâtre parce qu’il occupe une place tout à fait particulière : il est sur scène. Dès lors, cet élément physique devient un élément important puisqu’il exprime le pouvoir d’agir du metteur en scène qui a fait le choix de mettre cet objet physique dans le décor. Ce choix se modélise dans la dimension des rapports par une relation entre le téléphone sur la scène (dimension physique), le metteur en scène (dimension acteur) et le choix (dimension concepts).

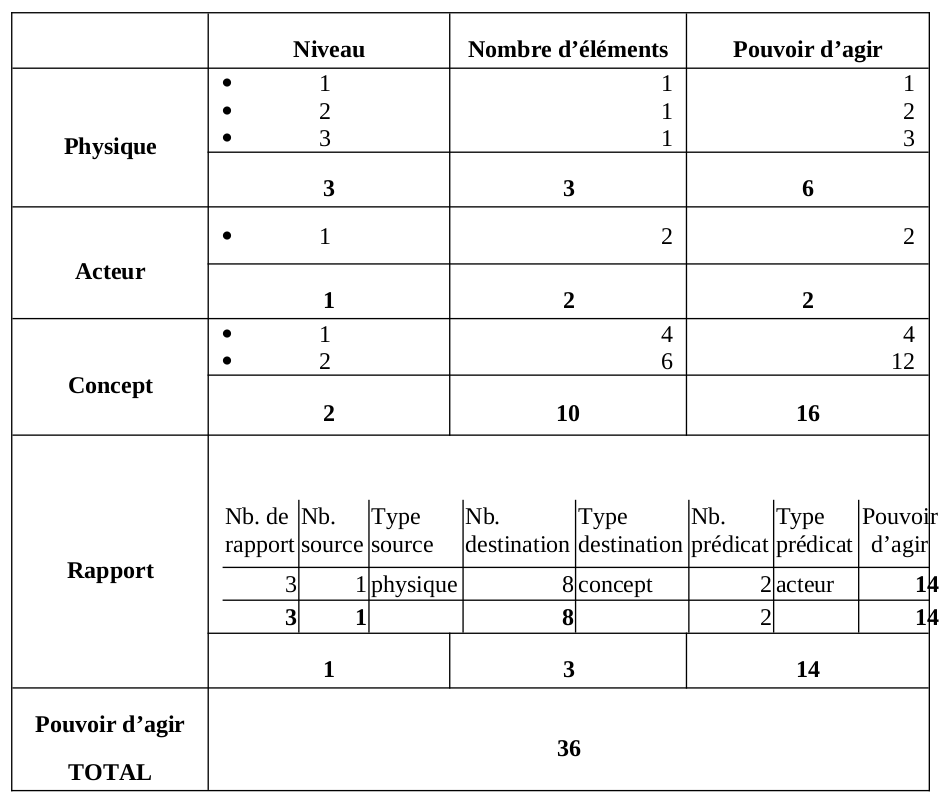

De ce point de vue et suivant le calcul présenté dans la figure ci-dessus Figure 2.18 (b) le pouvoir d’agir du téléphone est de 9. Ce chiffre s’obtient parce que nous ne détaillons pas la modélisation en précisant, par exemple dans la dimension des concepts, à quel domaine le concept de choisir s’applique (la forme, la couleur, la position sur scène…) ou encore quelles intentions le metteur en scène met dans ces choix. De même, nous pouvons ajouter le scénographe et son équipe ce qui augmente le pourvoir d’agir de la dimension des acteurs, mais aussi celui de la dimension conceptuelle en faisant apparaître la notion de discussion et/ou de négociation. En prenant en compte ces nouveaux points de vue Figure 2.19, le pouvoir d’agir du téléphone augmente (36) Figure 2.18 (b) parce que le pouvoir de discernement du modélisateur augmente.

Examinons-nous maintenant le pouvoir d’agir du téléphone dans une perspective d’analyse de l’intention en donnant une place au public pour évaluer par exemple les questions suivantes : le téléphone est-il vu ? Quelle est son importance ? Les intentions du metteur en scène sont-elles comprises ? Dans ce cas, le pouvoir d’agir du téléphone n’est plus uniquement dépendant du pouvoir de discernement d’un modélisateur, mais aussi de celui des acteurs de l’écosystème. On passe d’une évaluation statique du pouvoir d’agir basé sur un état particulier de la modélisation sous la forme d’un modèle figé par une personne, à une évaluation dynamique calculée à partir des multiples instanciations de ce modèle lors de la réception d’un événement particulier par une personne particulière. La question qui se pose alors est la suivante : comment transformer l’attention des spectateurs en instanciation d’un modèle ? Ou dis autrement : comment capter le pouvoir de discernement des individus pour calculer le pouvoir d’agir d’une existence ? Nous ne pouvons répondre en détail à cette question qui soulève des problématiques d’ergonomie, de design des connaissances et d’expérience utilisateur. Indiquons toutefois que nous travaillons à des dispositifs numériques basés sur des cartographies sémantiques pour capter très finement le pouvoir de discernement ici et maintenant et calculer en temps réel le pouvoir d’agir d’un existant informationnel dans un écosystème de connaissances. Ce type de dispositif est notamment expérimenté dans le cadre du projet Arcanes (Bourassa, Larrue, Godin, & Szoniecky, 2019)

2.4.5 À suivre

Les principes que nous venons d’exposer et l’exemple que nous avons présenté traitent le téléphone sans prendre en compte son pouvoir agentiel en tant que matière vibrante qui agit comme tous les objets du décor. Il faudrait sans doute approfondir la modélisation pour faire apparaître ces activités, d’autant plus pour le téléphone qui en tant que dispositif numérique, possède des capacités de dynamisme et d’interaction qu’un élément purement matériel comme une table ne possède pas. On ne peut réduire la capacité d’agir d’un dispositif numérique à sa dimension physique puisqu’il impacte aussi les dimensions sociales en créant des réseaux de personnes et les dimensions conceptuelles en favorisant l’interopérabilité sémantique. La méthode que nous proposons permet d’analyser finement ces « nouvelles matérialités » en modélisant les écosystèmes de connaissances dans lesquels ces dispositifs évoluent. Afin d’analyser l’évolution du pouvoir d’agir des acteurs dans ces écosystèmes, nous concevons un design éthique par l’intégration du modèle de l’existant informationnel dans les dispositifs numériques que nous développons. Ainsi nous sommes en mesure de décrire précisément les pouvoirs d’agir que nous discernons dans les dispositifs et de quantifier ses augmentations et ses diminutions au fur et à mesure de leurs usages. Nous espérons ainsi stimuler les réflexions et les débats sur la place du numérique dans le spectacle vivant et plus globalement dans un monde de plus en plus occupé par des objets connectés (Saleh, Ammi, & Szoniecky, 2018).

Voir la cérémonie du changement de note : https://www.youtube.com/watch?v=_3BBgQPuPI0↩︎

Cours de Deleuze du 09/12/1980 http://www2.univ-paris8.fr/deleuze/article.php3?id_article=137↩︎

Précisons toutefois que l’humain est particulière efficace pour la paréidolie (Dufort, Tajariol, & Roxin, 2015), ce qui lui permet de donner du sens à des formes ambiguës et donc de créer des signifiés quelles que soient les parties extensives qu’il discerne.↩︎

Retable polyptyque du Jugement Dernier de Rogier van der Weyden aux Hospices de Beaune, 1443-1452, https://commons.wikimedia.org/w/index.php?curid=6028656↩︎

Le chiffre correspond au nombre d’adresses définies dans le dictionnaire IEML à la date du 25/01/2023. Ce travail toujours en train de se faire est consultable ici : https://github.com/plevyieml/ieml-language/↩︎

L’éditeur IEML était accessible (https://dev.intlekt.io/), mais n’est plus accessible↩︎

Pour un historique rapide des différentes implémentations : https://intlekt.io/histoire/↩︎

Cet algorithme est utilisable directement avec une API pour un petit nombre d’éléments ou avec un « Writer » pour le module Bulk Export développé par Daniel Bertherau (https://gitlab.com/Daniel-KM/Omeka-S-module-BulkExport). Le code de l’algorithme est disponible ici : https://github.com/samszo/Omeka-S-module-JDC/blob/master/src/View/Helper/JDCViewHelper.php#L169

> le writer ici :https://github.com/samszo/Omeka-S-module-JDC/blob/master/src/Writer/AbstractComplexityWriter.php↩︎La liste des correspondances est disponible ici : https://github.com/samszo/Omeka-S-module-JDC/blob/master/src/View/Helper/JDCViewHelper.php#L39↩︎

Il est important de noter que le calcul de la complexité d’une existence tel qu’il est aujourd’hui, ne prend pas en compte l’intégralité du réseau informationnel dont fait partie cette existence, mais uniquement les éléments qui la constitue. Par exemple, pour le calcul d’une existence A, on ne prend pas en compte les existences B, C ou D dont la valeur d’une de leurs propriétés est A. Nous avons fait ce choix pour minimiser le temps de calcul et parce que nous pensons qu’une existence peut se définir uniquement par les éléments qui la composent sans prendre en compte les existences qu’elle contribue à définir. Ce choix de calcul est bien évidemment discutable et revient à s’interroger sur les rapports entre la transcendance c’est-à-dire la puissance de ce à quoi l’existence participe et l’immanence c’est-à-dire la puissance de ce qui compose une existence. Le débat est ouvert.↩︎

Cette information n’est présente que dans les calculs via l’API, mais pas avec le module Export↩︎

Cette information n’est présente que pour les ressources de niveau 1 dans les calculs via l’API, mais pas avec le module Export↩︎

Explication des notes du tableau 2 : Terre 3 : Œuvre et héâtre 4 : Scène 5 : Somme des éléments de la cellule supérieure (1+4+3=8) 6 : Théâtre, compagnie, auteurs, publics. 7 : Nombre de personnes composant les publics. 8 : Somme des éléments de la cellule supérieure (4+396=400) 9 : Diriger, accueillir, sécuriser, gérer, concevoir, jouer, mémoriser, diriger, créer, choisir, lire, voir, écouter. 10 : Report de la donnée figurant dans la cellule supérieure, car, dans ce cas, aucune somme n’est nécessaire. 11 : Terre, œuvre et théâtre. 12 : Théâtre, compagnie, auteurs, publics. 13 : Somme du nombre de rapports (13), du nombre de sources (13), du nombre de destinations (3) et du nombre de prédicats (4). 14 : Report de la donnée figurant dans la cellule supérieure, car, dans ce cas, aucune somme n’est nécessaire. 15 : Somme des complexités des physique (8), des acteurs (400), des concepts (13) et des rapports (33). 16 : Pour les trois dimensions physique, acteur et concept, les chiffres du tableau correspondent au nombre d’éléments de chacune des dimensions pour chacun des niveaux de détails. Par exemple pour la dimension physique le niveau 1 est composé de 1 élément (Terre), le niveau 2 de 2 éléments (théâtre, œuvre) le niveau 3 de 1 élément (scène). Le pouvoir d’agir correspond à la multiplication du nombre d’éléments par le niveau de détails. Pour les rapports les chiffres correspondent au nombre d’éléments pour chaque triplet « source – destination - prédicat », la complexité est la somme de ces éléments.↩︎